Metodi scientifici di base

| Faculté | Faculté des sciences de la société |

|---|---|

| Département | Département de science politique et relations internationales |

| Professeur(s) | Marco Giugni[1] |

| Cours | Introduction aux méthodes de la science-politique |

Lectures

Sfide all'inferenza empirica nelle scienze politiche

Definizione

- inferire: trarre conclusioni generali da fatti, dati osservazionali e dati sperimentali. Un contesto di inferenza empirica esiste quando si vogliono stabilire legami e relazioni tra fattori esplicativi e spiegare sulla base di dati concreti o empirici.

- causalità: Come giudicare le relazioni causa-effetto è una questione centrale, specialmente nella metodologia.

- empirico: trarre conclusioni generali da prove empiriche.

Le tre sfide

Multi-causalità

- presque tout à un impact : c'est déterminé par une multiplicité de causes possibles ; ex, le comportement de vote politique n'est pas déterminé par une cause, il y a plusieurs facteurs. Un exemple est le niveau d'éducation, mais il y a d‘autres facteurs contextuels qui interviennent : sexe, position dans les classes.

- chaque phénomène a plusieurs causes : on peut difficilement défendre une position qui dit qu’un phénomène donné n’a qu’une seule cause. Lorsqu’il y a plusieurs facteurs, cela complique la tâche.

Condizionalità del contesto

Collegato al benchmarking; esiste un canale istituzionale che permette ai cittadini di partecipare, il che aiuta a spiegare perché le persone partecipano in Svizzera, ma non in altri paesi dove non esiste una democrazia diretta. Le cause di un fenomeno possono variare da un contesto all'altro. Il legame tra classe e voto dimostra che c'è condizionalità nel contesto e modifica il rapporto che può esistere tra due fattori che possono essere studiati. Ci sono effetti variabili nel contesto.

- L'effetto di quasi tutto dipende da quasi tutto il resto.

- Gli effetti di ciascuna causa tendono a variare da un contesto all'altro.

Endogeneità

Cause ed effetti si influenzano a vicenda; questo è il problema maggiore negli studi empirici, specialmente quelli che seguono l'approccio dell'osservazione. Ad esempio: l'interesse politico influenza la partecipazione (forte correlazione tra interesse (indipendente) e partecipazione (dipendente)). Il problema è che la causalità può essere invertita: "ciò che voglio spiegare può spiegare ciò che si suppone spieghi ciò che volevo spiegare".

È la difficoltà di distinguere tra "ciò che voglio spiegare" e il fattore che spiega questo fenomeno. La causa diventa un effetto e viceversa.

- Quasi tutto causa quasi tutto il resto.

- Cause ed effetti si influenzano a vicenda.

Spesso è difficile dire in quale direzione vada la causalità che si vuole applicare.

Il concetto di causa

Determinazione del rapporto di causalità

Nell'approccio scientifico delle scienze sociali, l'obiettivo è quello di determinare le relazioni causali.

"Se C (causa), allora E (effetto).

Non e' abbastanza! Il rapporto tra C ed E può a volte o sempre essere utile. Esempio - Dobbiamo essere un po' più specifici. Se diciamo che se c'è un alto livello di istruzione, possiamo dire che c'è un livello di partecipazione più elevato. Si sostiene che se c'è C allora c'è E, non c'è univocità del rapporto mentre il rapporto di causa ed effetto deve essere univoco.

"Se C, allora (e solo allora) sempre E.

In questo caso ci sono le quattro caratteristiche della relazione causa-effetto:

- Condizionalità: effetto a condizione che vi sia una causa.

- Successione: prima la causa, poi l'effetto.

- Coerenza: "Sempre" ogni volta che la causa è presente, si osserva anche l'effetto.

- Univocità: il legame è unico.

Vengono introdotti elementi importanti per definire che cos'è una causa. - non è ancora abbastanza! Esempio: se il livello di istruzione è alto, allora e solo allora c'è sempre una maggiore partecipazione.

Tuttavia, secondo alcuni, nell'epistemologia della scienza, manca l'elemento che consiste nel dire che ci deve essere un legame genetico, un legame nella produzione dell'effetto dovuto alla causa.

"Se C, allora (e solo allora) E sempre prodotto da C".

VERO: Un dato effetto non solo deve essere correlato ad una causa, ma l'effetto deve essere prodotto e generato da quella causa. La distinzione è più filosofica che sostanziale.

Definizione di cosa sia una causa

- è generato da , quindi non basta osservare una covarianza tra una causa ed un effetto, ma è necessario, per parlare di causa, che l'effetto sia generato dalla causa.

- La causa deve produrre l'effetto. (ad esempio, se si ha un alto livello di istruzione, questo genera la partecipazione alla politica).

Fondamentalmente, nel contesto del pensiero causale, appartiene solo al livello teorico. Quando parliamo di causa, siamo su un piano puramente teorico e non empirico. Pertanto, non si può mai dire che empiricamente, una variazione di produce una variazione di .

Non possiamo mai riuscire a stabilire relazioni di causa-effetto a livello teorico, possiamo farlo solo a livello empirico.

Se osserviamo empiricamente, sulla base dei dati, che una variazione di e regolarmente seguita da una variazione di ,

possiamo dire che c'è un elemento di conferma empirica di un'ipotesi causale. Occorre distinguere tra il livello teorico e il livello causale, che è il livello empirico che può essere affrontato solo attraverso lo studio delle covariazioni.

In altre parole, se osserviamo che una variazione di e regolarmente seguita da una variazione di, c'è un elemento di corroborazione, ma ogni altra possibile causa deve ancora essere eliminata. Empiricamente, il compito è quello di dire che vogliamo trovare una covariata, ma poiché c'è la multicausalità, come possiamo assicurarci che questa covariata esista realmente e affermare che abbiamo un elemento di corroborazione empirica dell'assunzione del rapporto di causa-effetto?

Corrosione empirica di una relazione causale

Se osserviamo empiricamente che una variazione di è regolarmente seguita da una variazione di mantenendo costanti tutti gli altri. (altre cause e fattori esplicativi) esiste un forte elemento di corroborazione scientifica dell'ipotesi che o la causa di .

Nella ricerca empirica non potremmo mai parlare di causa ed effetto; dobbiamo tenere presente che il rapporto di causa-effetto rimane nell'ambito della teoria, empiricamente possiamo avvicinarci solo in certe condizioni, trovando la covarianza e mantenendo costanti gli altri fattori.

- covarianza tra variabili dipendenti (dipende) e indipendenti (causa, non dipende da nient'altro): entrambe devono variare.

- direzione causale: è necessario dare una direzione alla causalità, il problema dell'endogeneità.

- Impossibilità logica: se si ha una teoria della classe sociale che influenza l'orientamento politico, è ovvio che è la classe che determina. La causalità non può essere invertita.

Va ricordato che nelle scienze sociali vogliamo muoverci verso un'idea di spiegazione causale. Tuttavia, questo non può mai essere fatto, perché sul piano epistemologico l'idea di causa ed effetto è a livello teorico. A livello empirico, possiamo parlare solo di "variazione", ma in certe condizioni possiamo confermare, cioè verificare empiricamente una relazione causale.

Corrosione empirica di una relazione causale

Ci sono tre condizioni da soddisfare per verificare empiricamente una relazione causale.

Covariazione tra variabili indipendenti e dipendenti

- variazione della variabile indipendente: questa è la causa () ex: istruzione

- variazione della variabile dipendente: dipende da , è l'effetto; per esempio, la partecipazione - quello che si suppone che tu debba spiegare deve variare! Anche la variabile indipendente!

Al massimo, la relazione causale teorica può essere corroborata empiricamente.

Direzione causale

"Non posso dire se questo e che determina l'attributo o il contrario". Ci sono tre modi per determinare la direzione causale e per avvicinarsi all'ideale teorico per definire una relazione causa-effetto.

- manipolazione della variabile indipendente: analisi sperimentale, questi sono diversi metodi scientifici fondamentali.

- successione temporale: ci sono alcune variabili che logicamente precedono altre variabili. Ad esempio, la socializzazione primaria precede (influenza) il comportamento di voto di una persona che ha 30 anni. (in questo caso il problema dell'endogeneità è risolto). In alcuni casi ci sono successioni ovvie. A livello empirico questo è importante per determinare una direzione verso la causalità.

- impossibilità logica: la classe sociale non determina l'orientamento politico. Ci sono alcuni fattori che non possono dipendere da altri fattori. Ci sono impossibilità logiche che rendono possibile stabilire il rapporto di causa-effetto.

Controllo di variabili esterne

Dal punto di vista empirico, si potrebbe dire che il livello di partecipazione politica varia a seconda di diverse variabili. Questo è lo scopo del controllo delle variabili esterne. Si può dire che il 90 per cento di ciò che facciamo nella ricerca nel campo delle scienze sociali è garantire che possiamo controllare l'effetto di fattori esplicativi che non ci interessano. Elemento determinante: controllo delle altre variabili.

- applicazione della regola "ceteris paribus": il rapporto di causa-effetto può essere determinato sapendo che il resto non è coinvolto, a parità di tutte le altre cose. C'è una relazione tra un dato fenomeno e un altro fenomeno, a parità di tutte le altre cose, cioè dobbiamo fare in modo che tutti gli altri fattori si possano dire controllati o, in altre parole, resi costanti.

- dipende dalla logica del design della ricerca: è il mio modo di controllare il ruolo di altre potenziali cause che dipendono dal design del modello di ricerca. Dipende dalla logica del design di ricerca; design di ricerca osservazionale. Il modo di aggirare questo problema è diverso a seconda del modello di ricerca. L'obiettivo è quello di controllare l'effetto di altre cause potenziali di cui vogliamo mostrare l'effetto.

Nesso di causalità ingannevole

Definizione

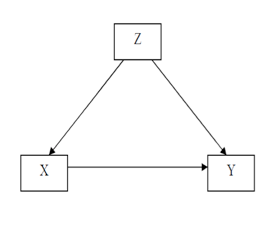

Relation causale fallacieuse (spirious) : c’est une relation causale apparente, mais inexistante, on pensait avoir trouvé une relation causale, mais finalement il n'y avait pas de relations causales, mais seulement une covariation. C'est une covariation entre deux variables ( ; ) qui ne découle pas d’un lien causal entre et , mais dépend du fait que et sont influencés par une troisième variable . La variation de produit la variation simultanée de et sans qu'il y ait une relation causale entre le deux.

Il y a toujours le danger qu’une relation observée ne soit pas l’indice d’une relation causale.

Exemple de relation causale fallacieuse

Exemple 1

L’intention de vote est influencée par plusieurs facteurs (âge, genre, éducation, classe sociale, orientation politique de la famille, etc.).

On peut trouver un lien entre éducation () et vote (), mais finalement c'est la classe sociale () qui détermine les deux. Dès lors faut introduire des variables de contrôle !! Sinon cela peut être qu'une covariation n’ayant pas de lien de causalité.

Utilisation de la télévision de la part de deux candidats () à l’élection présidentielle pour communiquer leur programme.

On veut expliquer le vote (), mais le vote est influencé par plusieurs facteurs qui jouent un rôle comme l’éducation, mais c’est la classe sociale qui engendre une multicausalité. L’idée est de constater l’effet de l’exposition à la campagne de télévision sur les électeurs. Ainsi on trouve une relation très forte entre et . Peut-on faire confiance à la covariation entre et ?

Les électeurs qui ont suivi la campagne en télévision () ont voté plus nombreux pour un des deux candidats (). On pourrait dire que l'exposition à la campagne produit le vote, mais il faut tenir en compte que : les électeurs plus âgés () regardent plus souvent la télévision, donc l’âge influence le vote (vieux droite, jeunes gauche).

L’âge (Z) influence à la fois l’exposition à la campagne en télévision (), les plus âgés restent à la maison et regardant la télé, et le vote pour un des deux candidats ().

Ainsi, la covariation entre et n’est pas vérifiée, car la variable influence les deux autres variables en même temps. Pour cela il faut introduire une variable de contrôle.

On va s'intéresser à des facteurs qui de manière plausible expliquent ce que nous voulons expliquer.

Exemple 2

Par exemple, si on s’intéresse au nombre de frigos et au niveau de démocratie, prétendre d’un lien entre les deux n’est pas pertinent. Cependant on pourrait expliquer qu’une troisième variable qui serait le degré d’urbanisation engendre la démocratie selon certaines théories et fait en même temps augmenter le nombre de frigos. Ainsi la covariation n’est pas une relation de cause à effet, car il y a une troisième variable qui influence les deux et qui est une relation de cause à effet.

Exemple 3

Si la participation politique () est expliquée par l’engagement associatif () on pourrait penser que cette relation est rendue fallacieuse du fait qu’il y ait une autre variable qui influence à la fois la participation et l’engagement associatif. Cette variable () pourrait être la participation politique. À nouveau il y a relation fallacieuse ; on ferait une erreur si on conclut à partir de la simple observation de cette relation qu’il y a un lien de cause à effet entre et parce qu’on n’a pas contrôlé l’effet d’une autre variable.

Deux manières pour contrôler empiriquement une affirmation causale

Dans le cas de problèmes liés aux relations causales fallacieuses (multicausalité et endogénéité), il y a deux manières de contrôler empiriquement l’affirmation causale.

Analyse de la covariation (donnée d’observation)

- contrôle : transformation des variables étrangères () en constantes, donc elle n'a pas d'effets, car il n'y a pas de covariation, elle ne varie pas. On doit tenir compte des possibilités des relations fallacieuses. (ex. on regarde parmi tous ceux qui vont à l'université dans la classe sociale la plus haute, et après on analyse leur vote ; donc la classe ne va pas jouer un rôle dans l’analyse). On peut faire ce contrôle manuellement.

- dépuration : contrôle statistique. On fait un modèle statistique, on introduit que la variable , qui nous intéresse, on introduit des variables avec une forte relation, après on introduit les autres variables de contrôle, et si on trouve encore un effet entre et , cela signifie que la relation n'était pas fallacieuse. Ceci est fait par un ordinateur qui calcule les relations entre toutes les variables et considère aussi toutes les relations de covariation. À la fin il détermine s'il y a une corrélation fallacieuse ou non. Le contrôle statistique est une manière de procéder au contrôle des variables et permet de tester le lien de cause à effet de façon empirique.

Expériment (données expérimentales)

C’est la mise en place d’une méthode expérimentale. Dans l'analyse de la covariation on agit une fois qu'on a les données en d’autres termes on manipule après coup les données a priori à partir du dessin de recherche, tandis que dans la méthode expérimentale on agit avant (comment-a-t-on produit les données?). On utilise la méthode expérimentale de manière à éviter une relation fallacieuse, on divise un échantillon en deux groupes et on choisit des individus au hasard. Selon la loi des grands nombres, on peut démontrer que les deux groupes sont semblables, donc, l'unique différence sera la variable indépendante.

Conclusion : c’est une réflexion autour de la causalité ; on a dit que la question de causalité reste au niveau théorique, on ne peut qu'essayer de se rapprocher de cet idéal. Il faut chercher une corrélation, mais il faut écarter des hypothèses (contre des variables), si on ne le fait pas on peut tomber dans une relation causale fallacieuse.

Covariation : peut être proche d'une relation causale, mais c'est l'effet d'une (variable non-observée) qui influence ce que nous voulons expliquer (dépendant) et ce qui expliquerait ce que nous voulons expliquer (indépendant). Une variable influence les deux autres variables en même temps, il y a aussi la possibilité d’une interaction entre variables explicatives.

Comment faire le contrôle des variables pour éviter de tomber dans une relation fallacieuse ? On distingue deux manières :

- analyse de la covariation : on observe (données observationnelles) après avoir les données.

- contrôle : on va rendre une variable étrangère en constante, lorsqu’on a une relation supposée entre deux variables qui est rendue fallacieuse, car il y a une troisième variable, on prend une partie des individus qui correspond à la deuxième variable, par exemple, on prend de gens du même âge, pour la relation de comportement entre l’exposition à la télé et le vote. Donc on a contrôlé cette valeur, on l'a rendue constante.

- dépuration : c'est un contrôle statistique. Dépuration pour toutes les variables.

- analyse expérimentale : on met en place un design de recherche qui évite l'existence des variables Z qui pourront affecter notre analyse.

Quatre méthodes scientifiques fondamentales selon Arend Lipjhart

On peut mentionner trois voire quatre méthodes :

- Méthode expérimentale (se différencie des autres)

- Méthode statistique

- Méthode comparative

- Étude de cas

Ce sont les trois méthodes fondamentales qui permettent de faire un contrôle des variables dit aussi des « facteurs explicatifs additionnables ». L’objectif est de tester des hypothèses et d’en écarter certaines en concurrence avec d’autres.

Les trois premières méthodes finalement ont toutes pour objectif principal de chercher des relations cause à effet, et cherchent à éliminer le bruit produit par des qui pourrait produire une relation fallacieuse, elles ont le même but, mais le poursuivent de façon diffèrent. Les trois établissent des propositions empiriques générales sous contrôle de toutes les autres variables (). Ilsveulent s'approcher du lien théorique de cause à effet entre un phénomène observé et des causes potentielles, il y a des degrés de réussite différents, on a vu que la méthode expérimentale et celle qui s’en rapproche le plus, sur les différents facteurs explicatifs. L’idée est d’arriver à une corroboration empirique d’affirmations causales.

Méthode expérimentale

Principes

- Attribution aléatoire : on prend au hasard, tous les individus ont la même chance d'être dans le groupe expérimental ou de contrôle des sujets (dans les groupes expérimentaux et de contrôle non-expérimentale). Cette idée née du principe de la loi des grands nombres : la variable aléatoire est censée écarter toute autre explication.

- Manipulation de la variable indépendante (traitement), en quoi les groupes sont-ils égaux ? le chercheur, à un certain moment, introduit un input dans l’un des deux groupes.

On sépare deux groupes faisant en sorte que les deux groupes soient pareils sur toutes les dimensions sauf sur un qui est celui sur lequel on veut tester l’effet. Le fait de choisir une personne et de l’attribuer d’une manière aléatoire fait que les deux groupes sont semblables. Si, ensuite, est introduit un traitement dans l’un des deux groupes et qu’on observe un changement qui n’est pas dans le groupe de contrôle, il se peut qu’il y ait un effet causal allant dans une réflexion cause à effet. On peut dès lors conclure qu’il y a un effet causal dans la variable introduite.

Types des experiments

- En laboratoire (laboratory experiment) : ce sont les expériences faites dans des laboratoires puis on divise les individus en groupes auxquels on applique des stimulus pour arriver à une constatation de l’effet ou du non-effet. Cependant, on sort les individus de leurs conditions naturelles pouvant mener à des résultats relevant de l’artificialité des conditions expérimentales.

- Sur le champ (field experiment) : contexte naturel, il peut y avoir d’autres facteurs qui interviennent. Ce sont des expérimentations qui ont été appliquées en science politique. Les principes restent les mêmes avec une distribution aléatoire des sujets en deux groupes ; on manipule la variable indépendante et ensuite on constate s’il y a eu un effet du traitement sur le groupe expérimental et non pas sur le groupe de contrôle. Dès lors on peut éviter la critique de l’artificialité des expérimentations en laboratoire.

- Dessin quasi-expérimental (quasi-experiment) : ce dessin garde à l’idée que le chercheur manipule la variable indépendante, mais il n’y a pas d’attributions aléatoires des sujets à un groupe expérimental et un groupe de contrôle. Si on fait cela, c’est qu’on ne peut pas distribuer aléatoirement en deux groupes, on est forcé de prendre les groupes qui existent en réalité. En d’autres termes, le chercheur contrôle le traitement, mais ne peut pas attribuer les sujets de manière aléatoire. Parfois, quand nous sommes sur le terrain, il est difficile de faire différemment. Généralement c'est cette méthode qu'on utilise, car il y a un facteur que nous ne pouvons pas contrôler.

Exemple

Un psychosociologue a voulu tester les effets des objectifs collectifs sur les relations interpersonnelles. Il voulait voir dans quelle mesure, lorsqu’on dit à un groupe de personne qu’il y a un objectif, les stéréotypes négatifs conflictuels disparaissent. C’est une expérience sur-le-champ dans des conditions naturelles. Il a laissé les enfants interagir entre eux, on fait coopérer les enfants entre eux ; le chercheur a essayé de créer une identité collective et a subdivisé le groupe en deux de manière aléatoire. Il les a fait jouer au football ; on a constaté l’émergence de rivalités voire même de stéréotypes négatifs vis-à-vis de l’autre équipe. Ensuite, il a remis le groupe ensemble est il a redéfini un objectif commun qui requiert la coopération. Après coup il a constaté que ces conflits, ces stéréotypes négatifs, ces hostilités se transformaient en une véritable coopération.

Méthode statistique

On ne peut pas faire un dessin de recherche qui a priori permette de tester s’il y a des relations de corrélations, mais on doit le faire après coup.

- manipulation conceptuelle (mathématique) de données observées empiriquement : on a des données d'observation ou on essaie de contrôler par contrôle statistique, avec les corrélations partielles. On fait une distinction entre les données expérimentales et les données d’observation.

- corrélations partielles : corrélation entre deux variables une fois qu’on est sorti de l’analyse, c’est-à-dire contrôler l’effet d’autres variables qui pourraient influencer ce que l’on veut expliquer. En d’autres termes c’est rendre les autres Z comme si elles étaient des constantes suite à un processus de dépuration. C’est une logique de contrôle des variables : on contrôle les variables qui pourraient influencer ce qu’on voudrait expliquer. Dans l’exemple sur le vote, tout ce qui pourrait expliquer le vote devrait être pris en considération surtout si on peut penser que ce facteur externe peut influencer à la fois le vote et la variable indépendante (exposition médiatique). Ainsi on peut savoir si on se rapproche d’un effet causal.

Ce qui est important est d’aller au-delà d’une simple analyse bivariée ; il faut aller vers une analyse multivariée ou on introduit dans le modèle explicatif d’autres variables.

Méthode comparative

Toute recherche en science sociale est de par sa nature comparative. On compare toujours implicitement ou explicitement quelque chose. On peut s'interroger sur les objectifs de la comparaison. Nous avons vu que les objectifs de toute méthode scientifique essaient d'établir des propositions empiriques générales en contrôlant toutes les autres variables, mais selon certains, comme Tilly, il y a quatre objectifs à la comparaison, c’est-à-dire que l'onconfronte des unités d’observation.

Les buts de la comparaison selon Charles Tilly sont :

- Individualiser (individualizing) – comparaison individualisante : le but est de souligner et de mettre en lumière les caractéristiques d’une unité d’analyse donnée sur un certain phénomène ;l’idée est de trouver des comparaisons, pour donner une spécificité à un certain cas donné exemple - dans les études de politique comparative, le cas est le pays, on compare des pays ; le but est par exemple de montrer certaines caractéristiques du système politique en Suisse par rapport aux autres pays. La démocratie directe détermine des valeurs politiques ; on peut comparer la démocratie directe suisse avec des pays qui ne l'ont pas. On pourra analyser l'impact de cette caractéristique sur les gens. Caractériser, individualiser, rendre plus spécifiques les caractéristiques d'un pays par rapport à un autre.

- Généraliser (generalizing) : on compare non pour individualiser, mais pour généraliser, on inclut le plus grand nombre de cas, établir des propositions empiriques générales. Pour certains, la généralisation est l’un des deux objectifs principaux de la méthode comparative. On étudie des comportements que l’on compare, on veut voir si les configurations et les effets que l’on trouve dans un contexte sont retrouvés dans un autre contexte.

- Chercher des variations systématiques (variation-finding) : le but est de chercher des variations systématiques et tester une théorie en écartant des théories concurrentes de celle qu'on veut mettre en évidence. Selon Tilly c'est la meilleure manière de comparer. On essaie de tester une hypothèse causale, ainsi on écarter des hypothèses rivales.

- Globaliser (encompassing) : le but est de globaliser (approche systémique) on inclut tous les pays du monde, ou toutes les unités de comparaison possible. L'idée est que si on enlève une de ces unités de comparaison, tout le système change. Pour le professeur Giugni, ceci n'est pas une approche comparative, car on ne compare pas.

Il y a des objectifs différents de la comparaison ; agir sur la sélection des cas c'est comparer.

Stratégies de comparaison pour chercher des variations systématiques (Przeworski et Teune) On peut faire une distinction entre deux stratégies de comparaisons, ce sont des logiques et des manières de procéder méthodologiquement dans le choix des cas. Ce sont des manières de traiter la question de la causalité lorsqu'on possède des données d'observation. On fait une distinction entre deux designs de recherche comparatifs, c'est la comparaison par cas analogue (similar) et par cas contraste (different). Chacune des possibilités a ses avantages et désavantages.

- Comparaison entre cas contrastés (most different systems design) : on choisit des cas qui sont les plus différents possibles

- Comparaison entre cas analogues (most similar systems design) : vise à contrôler toutes les variables sauf celle qu'on veut analyser (exemple France - Suisse).

Stuart Mill a réfléchi sur la manière d’analyser ce lien causal. En sélectionnant des cas différents pour arriver à cet idéal, on vise à la relation cause à effet. Mais nous ne sommes pas dans le contexte de contrôle statistique. Dans notre cas, à travers la sélection de cas, on essaie de se rapprocher de cet idéal.

Stuart Mill distingue deux cas :

- The method of agreement (the most different system design): la logique est de choisir des pays très différents, mais qui se ressemblent sur un facteur clef. Il y a X qui est présent partout. Ensuite on observe Y, puis il y a une similarité au niveau de la variable Y que l’on veut expliquer. La logique est de dire qu’on cherche des pays ou on retrouve le même phénomène qui est celui dont on veut prouver l’effet. On observe ce qui se passe est qu’à chaque fois qu’il y a X on retrouve Y. Y a ce moment-là est produit par X parce qu’il ne peut pas être produit par autre chose, car les autres facteurs des pays sont différents, on le retrouve nul part ailleurs. La logique est de choisir des cas très différents sur la plupart des facteurs auxquels on peut penser et ensuite on va voir s’il y a coprésence de la variable que l’on veut expliquer et celle qui explique.

- The method of difference (the most similar system design): on cherche des pays qui se ressemble le plus possible. On peut distinguer entre les cas positifs et négatifs. On va chercher des cas qui on le facteur A, B et C et des cas négatifs qui ont aussi A, B et C. Dans les cas positifs il y a un facteur présent qui n’est pas présent dans le cas négatif. Ainsi le vote est présent lorsque X est présent et absent lorsque X est absent. La conclusion est que X est la cause de l’effet Y, parce que la présence au moins de Y ne peut pas avoir été produite par A, B et C. On a rendu A, B et C en constante.

Exemple - most different system design : on a trois cas (1, 2, n) ; un cas peut être des individus, pays, etc. On a un nombre de qualités pour ces cas. Ceci sont des caractéristiques de différents pays (chômage, développement), X est la variable indépendante et on veut expliquer Y. Dans cette logique de comparaison, les cas sont très différents, mais ne sont similaires que dans une propriété. Donc cette variable explique le facteur, car il est l'unique facteur commun. Dans le tableau 2 on a des cas positifs et négatifs ; ces cas sont parfaitement semblables sur un nombre le plus élevé possible d’attributs, propriétés et variables, mais il y a une différence cruciale dans ce qui est censé d'expliquer ce que nous voulons expliquer. Il y a un facteur qui n'est pas présent. Dans un cas il y a Y dans l'autre pas ; on attribue la différence à la variable qui n'est pas dans les deux cas. Cette méthode essaie de se rapprocher de la démarche expérimentale, car il est fait en sorte que les deux groupes soient le plus proche possibles (ressemblent a, b, c), mais ils diffèrent avec la variable indépendante, most similar system design. Le professeur Giugni préfère cette manière, car elle se rapproche de l'idéal de l'expérimentation. Un exemple est d’étudier sur deux années des étudiants qui assistent au cours et de changer les diapositives qui sont données. Ensuite, on compare le résultat final (la note moyenne) dans les deux cas.

Exemple - most similar system design : je compare des pays que se ressemblent (la France et la Suisse), et je veux démontrer que la répression policière françaises est plus forte, c'est l'unique facteur diffèrent entre deux pays. Ensuite nous constatons que la radicalisation des mouvements sociaux est plus forte en France. Le problème est que les «A» à savoir les facteurs qui se ressemblent entre les deux pays, ne sont jamais égaux, mais seulement se ressemblent (ce problème ne se rencontre qu’avec la méthode du most similar research design, c’est pour cela qu’il y a des chercheurs qui préfèrent l'autre approche, dans lequel il ne faut que trouver les différences), on ne peut que se rapprocher à l'idéal. De plus nous retrouvons le problème de l'endogénéité c’est-à-dire de savoir quel facteur influence l'autre.

Étude de cas

C’est une méthode plus qualitative, elle diffère des trois autres méthodes, car elles s‘orientent plus vers la recherche quantitative-positiviste. Il y a quelques distinctions faites par Arend Lipihart, il y a une sorte de clivage, une distinction entre les données expérimentales et d’autre part les données d’observations.

Alors que la méthode expérimentale s’appuie sur l’idée de grand nombre, la méthode comparative un certain nombre de cas qui peuvent varier, l’étude de cas ne s’appuie que sur un seul cas. Toutefois on peut envisager une étude de cas qui peut s’étendre sur plus d’un cas, car la frontière est parfois souple.

L'étude de cas n'est que l'étude d'un seul cas, il n'a pas de la comparaison. Un cas peut être beaucoup des choses comme un parti, une personne ou encore un pays. On essaie d'étudier en profondeur un cas particulier, mais pas de façon extensive comme les trois autres méthodes qui n’étudient pas les cas autant en profondeur.

En d’autres termes, le grand avantage de l’étude de cas est qu’on peut aller beaucoup plus en profondeur dans la connaissance du cas. Une étude de cas est par définition intensive alors que l’étude quantitative est extensive. Une méthode est basée sur la standardisions avec l’idée de généraliser tandis que l’autre s’appuie sur l’interprétation en profondeur d’un cas spécifique.

Si la méthode statistique a pour objectif de généraliser, l’étude de cas par définition ne permet pas de généralisation, l’objectif est un autre. Il existe différentes études de cas et différentes modalités afin de mener une étude de cas. On peut en mentionner 6 variantes :

- les deux première ayant pour objectif de s’intéresser au cas précis.

- les quatre autres modalités ont un objectif de créer ou générer une théorie.

L’étude de cas peut servir pour atteindre des buts différents, d’une part on veut connaitre mieux une situation particulière de manière descriptive, d’autre part on peut étudier plusieurs cas permettant de générer à terme une théorie.

Selon Arend Lipihart, le but de la recherche est de tester et vérifier une théorie ainsi que de généraliser des résultats.

Ces deux cas ne veulent créer des hypothèses, l’idée est d'éclairer quelque chose par rapport à un cas :

- athéorique : il n’y a pas de théorie, c’est purement descriptif. C'est une recherche exploratoire, par exemple, l'étude d'une nouvelle organisation, on ne veut que la connaître et la décrire, dans ce cas on ne peut pas généraliser les résultats, car ils sont liés à un cas étudié en particulier. On l’utilise dans des situations ou des cas qui n’ont jamais été étudiés auparavant.

- interprétatif : on utilise des propositions théoriques qui existent dans la littérature, dans cette démarche qualitative le rôle de la littérature est moins important, on applique une généralisation existante à un cas donné, ici le cas porte sur un cas précis, sans volonté de créer une théorie tout comme l'athéorie. L'objectif n'est pas de confirmer ou de l'infirmer, mais c'est de l'appliquer seulement. On utilise des propositions ou des théories existantes qu’on applique à un cas ; on lui applique des généralisations existantes afin de voir si la généralisation tient de ce cas spécifique. On interprète une situation particulière à la lumière d’une théorie existante.

Le quatre qui suivent veulent créer une théorie ou tirer quelque chose des cas. Leur objectif est de créer ou de générer des théories ou des hypothèses :

- générant des hypothèses : on veut de créer des hypothèses là où il n'y en a pas. J’étudie un cas pas seulement parce qu’il m'intéresse, mais parce que je veux formuler des hypothèses que je vais après tester ailleurs. Ex : d'organisation qui s'engage en politique. On étudie une situation donnée, car on veut des hypothèses qu’on n’arrive pas à trouver par ailleurs. On explore un cas dans l’objectif de formuler des hypothèses. Les hypothèses ont essentiellement trois sources : la littérature existante, l’imagination sociologique, les études exploratoires.

- confirmant une théorie : tester une théorie sur un cas particulier pour confirmer cette théorie, ce type d'étude de cas n'est pas très utile, car ce n'est pas le fait qu’il y ait un cas qui reflète une théorie existante qui va renforcer la théorie faisant que ce système n'est pas très utile.

- infirmant une théorie : ceci a beaucoup plus de valeur, il y a une théorie qui est appliquée dans un cas spécifique, on ne cherche pas à confirmer la théorie, mais prouver qu'elle ne fonctionne pas, on cherche à infirmer une théorie. Ceci nous pousse à réfléchir sur la théorie, c’est quelque chose d’important dans le but d'élaborer une théorie.

- cas déviant : pourquoi un cas dévie de la généralisation, ce cas est très utile quand on veut infirmer une théorie. On cherche une situation qui dévie d’une situation existante, l’étude de cas cherche à montrer pourquoi ce cas dévie de la généralisation.

Annexes

- Elisabeth Wood - An Insurgent Path to Democracy: Popular Mobilization, Economic Interests and Regime Transition in South Africa and El Salvador," Comparative Political Studies, October 2001. Translation published in Estudios Centroamericános, No. 641-2, 2002. url: http://cps.sagepub.com/content/34/8/862.short