Los métodos científicos fundamentales

| Faculté | Faculté des sciences de la société |

|---|---|

| Département | Département de science politique et relations internationales |

| Professeur(s) | Marco Giugni[1] |

| Cours | Introduction aux méthodes de la science-politique |

Lectures

Desafíos a la inferencia empírica en la ciencia política

Definición

- inferir: sacar conclusiones generales a partir de hechos, datos observacionales y datos experimentales. Existe un contexto de inferencia empírica cuando se quiere establecer vínculos y relaciones entre factores explicativos y explicar sobre la base de datos concretos o empíricos.

- causalidad: Cómo juzgar las relaciones causa-efecto es un tema central, especialmente en la metodología.

- empírico: sacar conclusiones generales de la evidencia empírica.

Los tres desafíos

Multi-causalidad

- casi todo tiene un impacto: está determinado por una multiplicidad de causas posibles; por ejemplo, el comportamiento de voto político no está determinado por una causa, hay varios factores. Un ejemplo es el nivel de educación, pero hay otros factores contextuales involucrados: género, posición en el aula.

- cada fenómeno tiene varias causas: es difícil defender una posición que dice que un fenómeno determinado tiene una sola causa. Cuando hay varios factores, esto complica la tarea.

Condicionalidad del contexto

En relación con la evaluación comparativa, existe un canal institucional que permite a los ciudadanos participar, lo que ayuda a explicar por qué la gente participa en Suiza, pero no en otros países donde no existe la democracia directa. Las causas de un fenómeno pueden variar de un contexto a otro. El vínculo entre clase y votación muestra que hay condicionalidad en el contexto y modifica la relación que puede existir entre dos factores que pueden ser estudiados. Hay efectos variables en todo el contexto.

- El efecto de casi todo depende de casi todo lo demás.

- Los efectos de cada causa tienden a variar de un contexto a otro.

Endogeneidad

Las causas y los efectos se influyen mutuamente; éste es el mayor problema en los estudios empíricos, especialmente los que siguen el enfoque de la observación. Por ejemplo: el interés político influye en la participación (fuerte correlación entre interés (independiente) y participación (dependiente)). El problema es que la causalidad puede invertirse: "lo que quiero explicar puede explicar lo que se supone que explica lo que quería explicar".

Es la dificultad de distinguir entre "lo que quiero explicar" y el factor que explica este fenómeno. La causa se convierte en un efecto y viceversa.

- Casi todo causa casi todo lo demás. Las causas y los efectos se influyen mutuamente.

- A menudo es difícil decir en qué dirección va la causalidad que se quiere aplicar.

Le concept de cause

Determinante de la relación causal

En el enfoque científico de las ciencias sociales, el objetivo es determinar las relaciones causales.

"Si C (causa), entonces E (efecto)"

No es suficiente! La relación entre C y E puede a veces o siempre valer la pena. Ejemplo - Necesitamos ser un poco más específicos. Si decimos que si hay un alto nivel de educación, podemos decir que hay un mayor nivel de participación. Se argumenta que si hay C entonces hay E, no hay univocidad de la relación mientras que la relación de causa y efecto debe ser inequívoca.

"Si C, entonces (y sólo entonces) siempre E"

En este caso están las cuatro características de la relación causa-efecto:

- Condicionalidad: efecto a condición de que exista una causa.

- Sucesión: primero la causa, luego el efecto.

- Consistencia: "Siempre que la causa está presente, también se observa el efecto.

- Univocidad: el vínculo es único.

Se introducen elementos importantes para definir qué es una causa. - enfoque todavía no es suficiente! Ejemplo: si el nivel de educación es alto, entonces y sólo entonces siempre hay una mayor participación.

Sin embargo, según algunos, en la epistemología de la ciencia, falta el elemento que consiste en decir que debe haber un vínculo genético, un vínculo en la producción del efecto debido a la causa.

"Si C, entonces (y sólo entonces) E siempre producido por C"

VERDADERO: Un efecto dado no sólo debe estar correlacionado con una causa, sino que el efecto debe ser producido y generado por esa causa. La distinción es más filosófica que sustancial.

Definición de lo que es una causa

- es generado por , por lo que no basta con observar una covarianza entre una causa y un efecto, sino que también es necesario, para hablar de causa, que el efecto sea generado por la causa.

- La causa debe producir el efecto. (por ejemplo, si tienes un alto nivel de educación, esto genera participación en la política).

Básicamente, en el contexto del pensamiento causal, pertenece sólo al nivel teórico. Cuando hablamos de causa, estamos en un nivel puramente teórico y no empírico. Por lo tanto, nunca se puede decir que empíricamente, una variación de produce una variación de .

Nunca lograremos establecer relaciones de causa y efecto a nivel teórico, sólo podemos hacerlo a nivel empírico.

Si observamos empíricamente, sobre la base de los datos, que una variación de y seguido regularmente por una variación de , podemos decir que hay un elemento de corroboración empírica de una hipótesis causal. Hay que distinguir entre el nivel teórico y el nivel causal, que es el nivel empírico al que sólo se puede llegar mediante el estudio de las covariaciones.

En otras palabras, si observamos que una variación de y seguido regularmente por una variación de , hay un elemento de corroboración, pero cualquier otra causa posible debe ser eliminada. Empíricamente, la tarea es decir que queremos encontrar una covariable, pero dado que hay multi-causalidad, ¿cómo podemos asegurarnos de que esta covariable realmente existe y afirmar que tenemos un elemento de corroboración empírica de la suposición de la relación causa-efecto?

Corrosión empírica de una relación causal

Si observamos empíricamente que una variación de es seguido regularmente por una variación de manteniendo a todos los demás constantes (otras causas y factores explicativos) hay un fuerte elemento de corroboración científica de la hipótesis de que es la causa de .

En la investigación empírica, nunca podríamos hablar de causa y efecto; debemos tener en cuenta que la relación causa-efecto permanece en la esfera de la teoría, empíricamente sólo podemos acercarnos bajo ciertas condiciones, encontrando la covarianza mientras mantenemos constantes los otros factores.

- covarianza entre variables dependientes (depende) e independientes (causa, no depende de nada más): ambas deben variar.

- dirección causal: es necesario dar una dirección a la causalidad, el problema de la endogeneidad.

- Imposibilidad lógica: si se tiene una teoría de la clase social que influye en la orientación política, es obvio que es la clase la que determina. La causalidad no puede ser revertida.

Hay que recordar que en las ciencias sociales queremos avanzar hacia una idea de explicación causal. Sin embargo, esto nunca puede hacerse, porque en el nivel epistemológico la idea de causa y efecto está en el nivel teórico. A nivel empírico, sólo podemos hablar de "variación", pero bajo ciertas condiciones podemos corroborar, es decir, verificar empíricamente una relación causal.

Corrosión empírica de una relación causal

Hay tres condiciones que deben cumplirse para verificar empíricamente una relación causal.

Covariable entre variables independientes y dependientes

- variación de la variable independiente: ésta es la causa () ej: educación

- variación de la variable dependiente: depende de , es el efecto; por ejemplo, la participación - ¡lo que se supone que se debe explicar debe variar! También la variable independiente!

A lo sumo, la relación causal teórica puede ser corroborada empíricamente.

Dirección causal

"No puedo decir si esta es la que determina el ou a lo contrario". Hay tres maneras de determinar la dirección de la causa y de acercarse al ideal teórico para definir una relación de causa y efecto.

- manipulación de la variable independiente: análisis experimental, estos son diferentes métodos científicos fundamentales.

- sucesión temporal: hay algunas variables que lógicamente preceden a otras variables. Por ejemplo, la socialización primaria precede (influye) en el comportamiento electoral de una persona de 30 años. (el problema de la endogeneidad se resuelve en este caso). En algunos casos hay sucesiones evidentes. A nivel empírico, esto es importante para determinar una dirección hacia la causalidad.

- imposibilidad lógica: la clase social no determina la orientación política. Hay algunos factores que no pueden depender de otros factores. Existen imposibilidades lógicas que permiten establecer la relación causa-efecto.

Control de variables ajenas

Empíricamente, se podría decir que el nivel de participación política varía en función de varias variables. Este es el objetivo de controlar las variables extranjeras. Se puede decir que el 90% de lo que hacemos en la investigación en ciencias sociales es para asegurarnos de que podemos controlar el efecto de los factores explicativos que no nos interesan. Elemento determinante: control de las otras variables.

- aplicación de la regla "ceteris paribus": la relación causa-efecto puede determinarse sabiendo que el resto no está involucrado, siendo todas las demás cosas iguales. Existe una relación entre un fenómeno dado y otro fenómeno, en igualdad de condiciones, es decir, que debemos garantizar que todos los demás factores puedan ser controlados o, en otras palabras, que sean constantes.

- depende de la lógica del diseño de la investigación: es mi manera de controlar el papel de otras causas potenciales que dependen del diseño del modelo de investigación. Depende de la lógica del diseño de la investigación; diseño de la investigación observacional. La manera de sortear este problema es diferente dependiendo del modelo de investigación. El objetivo es controlar el efecto de otras causas potenciales cuyo efecto queremos mostrar.

Relación causal falsa

Definición

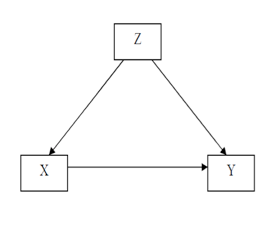

Relación causal falsa (espiritista): es una relación causal aparente, pero inexistente, pensábamos que habíamos encontrado una relación causal, pero finalmente no hubo relaciones causales, sino sólo una covariable. Es una covariable entre dos variables (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} ; Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} ) que no resulte de una relación causal entre Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} y Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} , pero depende del hecho de que Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} y Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} están influenciados por una tercera variable Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} . La variación de Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} produce la variación simultánea de Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} y Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y}

sin que exista una relación causal entre los dos.

Siempre existe el peligro de que una relación observada no sea indicativa de una relación causal.

Ejemplo de una relación causal falsa

Ejemplo 1

La intención de voto está influenciada por varios factores (edad, género, educación, clase social, orientación política de la familia, etc.).

Podemos encontrar un vínculo entre la educación (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} ) y votar (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} ), pero al final es de clase social (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} )

que determina a ambos. Por lo tanto, deben introducirse variables de control! De lo contrario, sólo puede ser una covariable sin relación causal.

Uso de la televisión por dos candidatos (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} )

en las elecciones presidenciales para comunicar su programa.

Queremos explicar el voto (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} ),pero el voto está influenciado por varios factores que juegan un papel como la educación, pero es la clase social la que genera una multi-causalidad. La idea es ver el efecto de la exposición a la campaña de televisión en los votantes. Por lo tanto, existe una relación muy fuerte entre Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} y Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} . ¿Podemos confiar en la covarianza entre Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} y Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} ?

Votantes que siguieron la campaña por televisión (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} ) votó en mayor número por uno de los dos candidatos (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} ). Se podría decir que la exposición a la campaña produce el voto, pero hay que tener en cuenta que: los votantes mayores (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} )

ver la televisión más a menudo, por lo que la edad influye en la votación (viejo a la derecha, joven a la izquierda).

La edad (Z) influye tanto en la exposición a la campaña como en la televisión (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} ), los mayores se quedan en casa y ven la televisión, y votan por uno de los dos candidatos (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} ).

Por lo tanto, la covarianza entre Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} y Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} no se verifica, porque la variable Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} influye en las otras dos variables al mismo tiempo. Para ello, se debe introducir una variable de control.

Examinaremos los factores que explican de manera plausible lo que queremos explicar.

Ejemplo 2

Por ejemplo, si nos interesa el número de frigoríficos y el nivel de democracia, es irrelevante reivindicar un vínculo entre ambos. Sin embargo, podría explicarse que una tercera variable, que sería el grado de urbanización, genera democracia según ciertas teorías y al mismo tiempo aumenta el número de refrigeradores. Por lo tanto, la covariable no es una relación causa-efecto, porque hay una tercera variable que influye en ambas y es una relación causa-efecto.

Ejemplo 3

Si la participación política (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} ) se explica por el compromiso asociativo (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} ) se podría pensar que esta relación es falaz por el hecho de que hay otra variable que influye tanto en la participación como en el compromiso asociativo. Esta variable (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} ) podría ser la participación política. Una vez más, existe una relación engañosa; sería un error concluir a partir de la mera observación de esta relación que existe una relación causal entre Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} y Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} porque no controlamos el efecto de otra variable.

Dos maneras de controlar empíricamente una afirmación causal

En el caso de problemas relacionados con relaciones causales engañosas (multicausalidad y endogeneidad), hay dos maneras de controlar empíricamente la alegación causal.

Análisis de covarianza (datos de observación)

- control: transformación de variables ajenas (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} ) en constantes, por lo que no tiene efectos, porque no hay covarianza, no cambia. Debemos tener en cuenta las posibilidades de relaciones engañosas (por ejemplo, buscamos entre todos los que van a la universidad en la clase social más alta, y luego analizamos su voto; por lo tanto, la clase no jugará un papel en el análisis). Este control se puede hacer manualmente.

- depuración: control estadístico. Hacemos un modelo estadístico, introducimos que la variable Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} , nos interesa, introducimos variables con una relación fuerte, luego introducimos las otras variables de control, y si todavía encontramos un efecto entre Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle X} y Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Y} , significa que la relación no era engañosa. Esto es hecho por una computadora que calcula las relaciones entre todas las variables y también considera todas las relaciones de co-variación. Al final determina si hay una correlación falsa o no. El control estadístico es una forma de controlar las variables y permite probar empíricamente la relación causa-efecto.

Experimento (datos experimentales)

Es la implementación de un método experimental. En el análisis de covarianza actuamos una vez que tenemos los datos, es decir, manipulamos los datos a priori desde el diseño de la investigación, mientras que en el método experimental actuamos antes (¿cómo producimos los datos?). El método experimental se utiliza para evitar una relación engañosa, una muestra se divide en dos grupos y los individuos se seleccionan al azar. De acuerdo con la ley de los grandes números, se puede demostrar que los dos grupos son similares, por lo que la única diferencia será la variable independiente.

Conclusión: es una reflexión en torno a la causalidad; se ha dicho que la cuestión de la causalidad permanece en el nivel teórico, sólo podemos intentar acercarnos a este ideal. Hay que buscar una correlación, pero hay que descartar hipótesis (contra variables), si no lo haces puedes caer en una relación causal engañosa.

Covariación: puede ser cercana a una relación causal, pero es el efecto de una Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} (variable no observada) que influye en lo que queremos explicar (dependiente) y en lo que explicaría lo que queremos explicar (independiente). Una variable influye en las otras dos variables al mismo tiempo, también existe la posibilidad de una interacción entre las variables explicativas.

¿Cómo controlar las variables para evitar caer en una relación engañosa? Hay dos maneras:

- análisis de covarianza: observamos (datos observacionales) después de tener los datos.

- control: haremos una constante de una variable ajena, cuando tengamos una relación asumida entre dos variables que se hace falaz, porque hay una tercera variable, tomamos una parte de los individuos que corresponde a la segunda variable, por ejemplo, tomamos a personas de la misma edad, para la relación conductual entre la exposición a la televisión y el voto. Así que comprobamos este valor, lo hicimos constante.

- depuración: es un control estadístico. Depuración para todas las variables.

- análisis experimental: establecemos un diseño de investigación que evita la existencia de variables Z que puedan afectar a nuestro análisis.

Cuatro métodos científicos fundamentales según Arend Lipjhart

Se pueden mencionar tres o incluso cuatro métodos:

- Método experimental (diferente a los demás)

- Método estadístico

- Método comparativo

- Estudio de caso

Estos son los tres métodos fundamentales que permiten controlar las variables también conocidas como "factores explicativos adicionales". El objetivo es probar hipótesis y descartar algunas de ellas en competencia con otras.

Los tres primeros métodos finalmente tienen el objetivo principal de buscar relaciones de causa y efecto, y buscan eliminar el ruido producido por Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} que podrían producir una relación engañosa, tienen el mismo propósito, pero lo persiguen de una manera diferente. Las tres establecen proposiciones empíricas generales bajo el control de todas las demás variables (Échec de l’analyse (MathML avec SVG ou PNG en secours (recommandé pour les navigateurs modernes et les outils d’accessibilité) : réponse non valide(« Math extension cannot connect to Restbase. ») du serveur « https://en.wikipedia.org/api/rest_v1/ » :): {\displaystyle Z} ). Quieren acercarse a la relación teórica de causa y efecto entre un fenómeno observado y las causas potenciales, hay diferentes grados de éxito, hemos visto que el método experimental y el que está más cerca de él, sobre los diferentes factores explicativos. La idea es llegar a una corroboración empírica de las declaraciones causales.

Método experimental

Principios

- Asignación aleatoria: seleccionados al azar, todos los individuos tienen la misma probabilidad de estar en el grupo experimental o en el grupo de control de sujetos (en los grupos de control experimental y no experimental). Esta idea nació del principio de la ley de los grandes números: se supone que la variable aleatoria excluye cualquier otra explicación.

- Manipulación de la variable independiente (tratamiento), ¿cómo son los grupos iguales? el investigador, en algún momento, introduce una entrada en uno de los dos grupos.

Separamos dos grupos para que los dos grupos sean iguales en todas las dimensiones excepto en una, que es sobre la que queremos probar el efecto. Seleccionar a una persona y asignarla al azar hace que los dos grupos sean similares. Si, posteriormente, se introduce un tratamiento en uno de los dos grupos y se observa un cambio que no está en el grupo de control, puede haber un efecto causal que entra en una reflexión de causa y efecto. Por lo tanto, puede concluirse que existe un efecto causal en la variable introducida.

Tipos de experimentos

- En el laboratorio (experimento de laboratorio): se trata de experimentos realizados en laboratorios y luego los individuos se dividen en grupos a los que se aplican estímulos para llegar a un hallazgo de efecto o no efecto. Sin embargo, los individuos son sacados de sus condiciones naturales que pueden conducir a resultados relacionados con la artificialidad de las condiciones experimentales.

- En el experimento de campo: contexto natural, puede haber otros factores involucrados. Se trata de experimentos que se han aplicado en la ciencia política. Los principios siguen siendo los mismos con una distribución aleatoria de los sujetos en dos grupos; la variable independiente se manipula y luego se determina si hubo un efecto del tratamiento en el grupo experimental y no en el grupo control. De este modo, se puede evitar la crítica de la artificialidad de los experimentos de laboratorio.

- Sorteo cuasi-experimental (cuasi-experimental): este sorteo tiene en cuenta que el investigador manipula la variable independiente, pero no hay asignaciones aleatorias de sujetos a un grupo experimental y a un grupo de control. Si hacemos esto, es porque no podemos distribuir al azar en dos grupos, nos vemos obligados a tomar los grupos que realmente existen. En otras palabras, el investigador controla el tratamiento, pero no puede asignar sujetos al azar. A veces, cuando estamos en el campo, es difícil hacer las cosas de manera diferente. Normalmente este es el método que usamos, porque hay un factor que no podemos controlar.

Ejemplo

Un psicosociólogo quería probar los efectos de los objetivos colectivos en las relaciones interpersonales. Quería ver hasta qué punto, cuando a un grupo de personas se les dice que hay un objetivo, desaparecen los estereotipos negativos contradictorios. Es una experiencia inmediata en condiciones naturales. Dejó que los niños interactuaran entre sí, los niños cooperaron entre sí; el investigador trató de crear una identidad colectiva y dividió al grupo en dos al azar. Los hizo jugar al fútbol; vimos la aparición de rivalidades e incluso estereotipos negativos hacia el otro equipo. Luego volvió a reunir al grupo y redefinió un objetivo común que requiere cooperación. Posteriormente, observó que esos conflictos, estereotipos negativos y hostilidades se transformaron en una verdadera cooperación.

Método estadístico

No podemos hacer un dibujo de investigación que a priori nos permita comprobar si existen relaciones de correlación, pero debemos hacerlo después del hecho.

- manipulación conceptual (matemática) de datos observados empíricamente: tenemos datos observacionales o intentamos controlarlos mediante control estadístico, con correlaciones parciales. Se hace una distinción entre datos experimentales y observacionales.

- correlaciones parciales: correlación entre dos variables una vez que se ha salido del análisis, es decir, controlando el efecto de otras variables que podrían influir en lo que se quiere explicar. En otras palabras, significa hacer las otras Zs como si fueran constantes después de un proceso de depuración. Es una lógica de control de variables: controlamos las variables que pueden influir en lo que nos gustaría explicar. En el ejemplo de la votación, cualquier cosa que pueda explicar el voto debe ser tomada en consideración, especialmente si se puede asumir que este factor externo puede influir tanto en el voto como en la variable independiente (exposición mediática). De esta manera podemos saber si nos estamos acercando a un efecto causal.

Lo importante es ir más allá de un simple análisis bivariado; es necesario avanzar hacia un análisis multivariado en el que se introduzcan otras variables en el modelo explicativo.

Método comparativo

Toda la investigación en ciencias sociales es por naturaleza comparativa. Siempre comparamos algo implícita o explícitamente. Uno puede preguntarse acerca de los objetivos de la comparación. Hemos visto que los objetivos de cualquier método científico intentan establecer proposiciones empíricas generales controlando todas las demás variables, pero según algunas, como Tilly, hay cuatro objetivos de comparación, es decir, la comparación de unidades de observación.

Los objetivos de la comparación según Charles Tilly son:

- Individualiser (individualizing) – comparaison individualisante : le but est de souligner et de mettre en lumière les caractéristiques d’une unité d’analyse donnée sur un certain phénomène ;l’idée est de trouver des comparaisons, pour donner une spécificité à un certain cas donné exemple - dans les études de politique comparative, le cas est le pays, on compare des pays ; le but est par exemple de montrer certaines caractéristiques du système politique en Suisse par rapport aux autres pays. La démocratie directe détermine des valeurs politiques ; on peut comparer la démocratie directe suisse avec des pays qui ne l'ont pas. On pourra analyser l'impact de cette caractéristique sur les gens. Caractériser, individualiser, rendre plus spécifiques les caractéristiques d'un pays par rapport à un autre.

- Généraliser (generalizing) : on compare non pour individualiser, mais pour généraliser, on inclut le plus grand nombre de cas, établir des propositions empiriques générales. Pour certains, la généralisation est l’un des deux objectifs principaux de la méthode comparative. On étudie des comportements que l’on compare, on veut voir si les configurations et les effets que l’on trouve dans un contexte sont retrouvés dans un autre contexte.

- Chercher des variations systématiques (variation-finding) : le but est de chercher des variations systématiques et tester une théorie en écartant des théories concurrentes de celle qu'on veut mettre en évidence. Selon Tilly c'est la meilleure manière de comparer. On essaie de tester une hypothèse causale, ainsi on écarter des hypothèses rivales.

- Globaliser (encompassing) : le but est de globaliser (approche systémique) on inclut tous les pays du monde, ou toutes les unités de comparaison possible. L'idée est que si on enlève une de ces unités de comparaison, tout le système change. Pour le professeur Giugni, ceci n'est pas une approche comparative, car on ne compare pas.

Il y a des objectifs différents de la comparaison ; agir sur la sélection des cas c'est comparer.

Stratégies de comparaison pour chercher des variations systématiques (Przeworski et Teune) On peut faire une distinction entre deux stratégies de comparaisons, ce sont des logiques et des manières de procéder méthodologiquement dans le choix des cas. Ce sont des manières de traiter la question de la causalité lorsqu'on possède des données d'observation. On fait une distinction entre deux designs de recherche comparatifs, c'est la comparaison par cas analogue (similar) et par cas contraste (different). Chacune des possibilités a ses avantages et désavantages.

- Comparaison entre cas contrastés (most different systems design) : on choisit des cas qui sont les plus différents possibles

- Comparaison entre cas analogues (most similar systems design) : vise à contrôler toutes les variables sauf celle qu'on veut analyser (exemple France - Suisse).

Stuart Mill a réfléchi sur la manière d’analyser ce lien causal. En sélectionnant des cas différents pour arriver à cet idéal, on vise à la relation cause à effet. Mais nous ne sommes pas dans le contexte de contrôle statistique. Dans notre cas, à travers la sélection de cas, on essaie de se rapprocher de cet idéal.

Stuart Mill distingue deux cas :

- The method of agreement (the most different system design): la logique est de choisir des pays très différents, mais qui se ressemblent sur un facteur clef. Il y a X qui est présent partout. Ensuite on observe Y, puis il y a une similarité au niveau de la variable Y que l’on veut expliquer. La logique est de dire qu’on cherche des pays ou on retrouve le même phénomène qui est celui dont on veut prouver l’effet. On observe ce qui se passe est qu’à chaque fois qu’il y a X on retrouve Y. Y a ce moment-là est produit par X parce qu’il ne peut pas être produit par autre chose, car les autres facteurs des pays sont différents, on le retrouve nul part ailleurs. La logique est de choisir des cas très différents sur la plupart des facteurs auxquels on peut penser et ensuite on va voir s’il y a coprésence de la variable que l’on veut expliquer et celle qui explique.

- The method of difference (the most similar system design): on cherche des pays qui se ressemble le plus possible. On peut distinguer entre les cas positifs et négatifs. On va chercher des cas qui on le facteur A, B et C et des cas négatifs qui ont aussi A, B et C. Dans les cas positifs il y a un facteur présent qui n’est pas présent dans le cas négatif. Ainsi le vote est présent lorsque X est présent et absent lorsque X est absent. La conclusion est que X est la cause de l’effet Y, parce que la présence au moins de Y ne peut pas avoir été produite par A, B et C. On a rendu A, B et C en constante.

Exemple - most different system design : on a trois cas (1, 2, n) ; un cas peut être des individus, pays, etc. On a un nombre de qualités pour ces cas. Ceci sont des caractéristiques de différents pays (chômage, développement), X est la variable indépendante et on veut expliquer Y. Dans cette logique de comparaison, les cas sont très différents, mais ne sont similaires que dans une propriété. Donc cette variable explique le facteur, car il est l'unique facteur commun. Dans le tableau 2 on a des cas positifs et négatifs ; ces cas sont parfaitement semblables sur un nombre le plus élevé possible d’attributs, propriétés et variables, mais il y a une différence cruciale dans ce qui est censé d'expliquer ce que nous voulons expliquer. Il y a un facteur qui n'est pas présent. Dans un cas il y a Y dans l'autre pas ; on attribue la différence à la variable qui n'est pas dans les deux cas. Cette méthode essaie de se rapprocher de la démarche expérimentale, car il est fait en sorte que les deux groupes soient le plus proche possibles (ressemblent a, b, c), mais ils diffèrent avec la variable indépendante, most similar system design. Le professeur Giugni préfère cette manière, car elle se rapproche de l'idéal de l'expérimentation. Un exemple est d’étudier sur deux années des étudiants qui assistent au cours et de changer les diapositives qui sont données. Ensuite, on compare le résultat final (la note moyenne) dans les deux cas.

Exemple - most similar system design : je compare des pays que se ressemblent (la France et la Suisse), et je veux démontrer que la répression policière françaises est plus forte, c'est l'unique facteur diffèrent entre deux pays. Ensuite nous constatons que la radicalisation des mouvements sociaux est plus forte en France. Le problème est que les «A» à savoir les facteurs qui se ressemblent entre les deux pays, ne sont jamais égaux, mais seulement se ressemblent (ce problème ne se rencontre qu’avec la méthode du most similar research design, c’est pour cela qu’il y a des chercheurs qui préfèrent l'autre approche, dans lequel il ne faut que trouver les différences), on ne peut que se rapprocher à l'idéal. De plus nous retrouvons le problème de l'endogénéité c’est-à-dire de savoir quel facteur influence l'autre.

Étude de cas

C’est une méthode plus qualitative, elle diffère des trois autres méthodes, car elles s‘orientent plus vers la recherche quantitative-positiviste. Il y a quelques distinctions faites par Arend Lipihart, il y a une sorte de clivage, une distinction entre les données expérimentales et d’autre part les données d’observations.

Alors que la méthode expérimentale s’appuie sur l’idée de grand nombre, la méthode comparative un certain nombre de cas qui peuvent varier, l’étude de cas ne s’appuie que sur un seul cas. Toutefois on peut envisager une étude de cas qui peut s’étendre sur plus d’un cas, car la frontière est parfois souple.

L'étude de cas n'est que l'étude d'un seul cas, il n'a pas de la comparaison. Un cas peut être beaucoup des choses comme un parti, une personne ou encore un pays. On essaie d'étudier en profondeur un cas particulier, mais pas de façon extensive comme les trois autres méthodes qui n’étudient pas les cas autant en profondeur.

En d’autres termes, le grand avantage de l’étude de cas est qu’on peut aller beaucoup plus en profondeur dans la connaissance du cas. Une étude de cas est par définition intensive alors que l’étude quantitative est extensive. Une méthode est basée sur la standardisions avec l’idée de généraliser tandis que l’autre s’appuie sur l’interprétation en profondeur d’un cas spécifique.

Si la méthode statistique a pour objectif de généraliser, l’étude de cas par définition ne permet pas de généralisation, l’objectif est un autre. Il existe différentes études de cas et différentes modalités afin de mener une étude de cas. On peut en mentionner 6 variantes :

- les deux première ayant pour objectif de s’intéresser au cas précis.

- les quatre autres modalités ont un objectif de créer ou générer une théorie.

L’étude de cas peut servir pour atteindre des buts différents, d’une part on veut connaitre mieux une situation particulière de manière descriptive, d’autre part on peut étudier plusieurs cas permettant de générer à terme une théorie.

Selon Arend Lipihart, le but de la recherche est de tester et vérifier une théorie ainsi que de généraliser des résultats.

Ces deux cas ne veulent créer des hypothèses, l’idée est d'éclairer quelque chose par rapport à un cas :

- athéorique : il n’y a pas de théorie, c’est purement descriptif. C'est une recherche exploratoire, par exemple, l'étude d'une nouvelle organisation, on ne veut que la connaître et la décrire, dans ce cas on ne peut pas généraliser les résultats, car ils sont liés à un cas étudié en particulier. On l’utilise dans des situations ou des cas qui n’ont jamais été étudiés auparavant.

- interprétatif : on utilise des propositions théoriques qui existent dans la littérature, dans cette démarche qualitative le rôle de la littérature est moins important, on applique une généralisation existante à un cas donné, ici le cas porte sur un cas précis, sans volonté de créer une théorie tout comme l'athéorie. L'objectif n'est pas de confirmer ou de l'infirmer, mais c'est de l'appliquer seulement. On utilise des propositions ou des théories existantes qu’on applique à un cas ; on lui applique des généralisations existantes afin de voir si la généralisation tient de ce cas spécifique. On interprète une situation particulière à la lumière d’une théorie existante.

Le quatre qui suivent veulent créer une théorie ou tirer quelque chose des cas. Leur objectif est de créer ou de générer des théories ou des hypothèses :

- générant des hypothèses : on veut de créer des hypothèses là où il n'y en a pas. J’étudie un cas pas seulement parce qu’il m'intéresse, mais parce que je veux formuler des hypothèses que je vais après tester ailleurs. Ex : d'organisation qui s'engage en politique. On étudie une situation donnée, car on veut des hypothèses qu’on n’arrive pas à trouver par ailleurs. On explore un cas dans l’objectif de formuler des hypothèses. Les hypothèses ont essentiellement trois sources : la littérature existante, l’imagination sociologique, les études exploratoires.

- confirmant une théorie : tester une théorie sur un cas particulier pour confirmer cette théorie, ce type d'étude de cas n'est pas très utile, car ce n'est pas le fait qu’il y ait un cas qui reflète une théorie existante qui va renforcer la théorie faisant que ce système n'est pas très utile.

- infirmant une théorie : ceci a beaucoup plus de valeur, il y a une théorie qui est appliquée dans un cas spécifique, on ne cherche pas à confirmer la théorie, mais prouver qu'elle ne fonctionne pas, on cherche à infirmer une théorie. Ceci nous pousse à réfléchir sur la théorie, c’est quelque chose d’important dans le but d'élaborer une théorie.

- cas déviant : pourquoi un cas dévie de la généralisation, ce cas est très utile quand on veut infirmer une théorie. On cherche une situation qui dévie d’une situation existante, l’étude de cas cherche à montrer pourquoi ce cas dévie de la généralisation.

Anexos

- Elisabeth Wood - An Insurgent Path to Democracy: Popular Mobilization, Economic Interests and Regime Transition in South Africa and El Salvador," Comparative Political Studies, October 2001. Translation published in Estudios Centroamericános, No. 641-2, 2002. url: http://cps.sagepub.com/content/34/8/862.short