« Metodi scientifici di base » : différence entre les versions

Aucun résumé des modifications |

|||

| (19 versions intermédiaires par le même utilisateur non affichées) | |||

| Ligne 7 : | Ligne 7 : | ||

| assistants = | | assistants = | ||

| enregistrement = | | enregistrement = | ||

| cours = [[ | | cours = [[Introduzione ai metodi della scienza politica]] | ||

| lectures = | | lectures = | ||

* [[ | * [[Corso introduttivo ai metodi della scienza-politica]] | ||

* [[ | * [[Il paradigma positivista e il paradigma interpretativo]] | ||

* [[ | * [[Metodi scientifici di base]] | ||

* [[ | * [[Dalla teoria ai dati]] | ||

* [[ | * [[La raccolta dei dati]] | ||

* [[ | * [[Trattamento dei dati]] | ||

}} | }} | ||

| Ligne 35 : | Ligne 35 : | ||

* chaque phénomène a plusieurs causes : on peut difficilement défendre une position qui dit qu’un phénomène donné n’a qu’une seule cause. Lorsqu’il y a plusieurs facteurs, cela complique la tâche. | * chaque phénomène a plusieurs causes : on peut difficilement défendre une position qui dit qu’un phénomène donné n’a qu’une seule cause. Lorsqu’il y a plusieurs facteurs, cela complique la tâche. | ||

=== | === Condizionalità del contesto === | ||

Collegato al benchmarking; esiste un canale istituzionale che permette ai cittadini di partecipare, il che aiuta a spiegare perché le persone partecipano in Svizzera, ma non in altri paesi dove non esiste una democrazia diretta. Le cause di un fenomeno possono variare da un contesto all'altro. Il legame tra classe e voto dimostra che c'è condizionalità nel contesto e modifica il rapporto che può esistere tra due fattori che possono essere studiati. Ci sono effetti variabili nel contesto. | |||

*L' | *L'effetto di quasi tutto dipende da quasi tutto il resto. | ||

* | *Gli effetti di ciascuna causa tendono a variare da un contesto all'altro. | ||

=== | === Endogeneità === | ||

Cause ed effetti si influenzano a vicenda; questo è il problema maggiore negli studi empirici, specialmente quelli che seguono l'approccio dell'osservazione. Ad esempio: l'interesse politico influenza la partecipazione (forte correlazione tra interesse (indipendente) e partecipazione (dipendente)). Il problema è che la causalità può essere invertita: "ciò che voglio spiegare può spiegare ciò che si suppone spieghi ciò che volevo spiegare". | |||

È la difficoltà di distinguere tra "ciò che voglio spiegare" e il fattore che spiega questo fenomeno. La causa diventa un effetto e viceversa. | |||

* | *Quasi tutto causa quasi tutto il resto. | ||

* | *Cause ed effetti si influenzano a vicenda. | ||

Spesso è difficile dire in quale direzione vada la causalità che si vuole applicare. | |||

= | = Il concetto di causa = | ||

{{Article détaillé|L’inférence causale}} | {{Article détaillé|L’inférence causale}} | ||

== | == Determinazione del rapporto di causalità == | ||

Nell'approccio scientifico delle scienze sociali, l'obiettivo è quello di determinare le relazioni causali. | |||

=== | ==="Se C (causa), allora E (effetto).=== | ||

Non e' abbastanza! Il rapporto tra C ed E può a volte o sempre essere utile. Esempio - Dobbiamo essere un po' più specifici. Se diciamo che se c'è un alto livello di istruzione, possiamo dire che c'è un livello di partecipazione più elevato. Si sostiene che se c'è C allora c'è E, non c'è univocità del rapporto mentre il rapporto di causa ed effetto deve essere univoco. | |||

=== | ==="Se C, allora (e solo allora) sempre E.=== | ||

In questo caso ci sono le quattro caratteristiche della relazione causa-effetto: | |||

*''' | *'''Condizionalità''': effetto a condizione che vi sia una causa. | ||

*''' | *'''Successione''': prima la causa, poi l'effetto. | ||

*''' | *'''Coerenza''': "Sempre" ogni volta che la causa è presente, si osserva anche l'effetto. | ||

*''' | *'''Univocità''': il legame è unico. | ||

Vengono introdotti elementi importanti per definire che cos'è una causa. - non è ancora abbastanza! Esempio: se il livello di istruzione è alto, allora e solo allora c'è sempre una maggiore partecipazione. | |||

Tuttavia, secondo alcuni, nell'epistemologia della scienza, manca l'elemento che consiste nel dire che ci deve essere un legame genetico, un legame nella produzione dell'effetto dovuto alla causa. | |||

=== "Se C, allora (e solo allora) E sempre prodotto da C". === | |||

VERO: Un dato effetto non solo deve essere correlato ad una causa, ma l'effetto deve essere prodotto e generato da quella causa. La distinzione è più filosofica che sostanziale. | |||

== Definizione di cosa sia una causa == | |||

*<math>E</math> è generato da <math>C</math>, quindi non basta osservare una covarianza tra una causa ed un effetto, ma è necessario, per parlare di causa, che l'effetto sia generato dalla causa. | |||

*La causa deve produrre l'effetto. (ad esempio, se si ha un alto livello di istruzione, questo genera la partecipazione alla politica). | |||

Fondamentalmente, nel contesto del pensiero causale, appartiene solo al livello teorico. Quando parliamo di causa, siamo su un piano puramente teorico e non empirico. Pertanto, non si può mai dire che empiricamente, una variazione di <math>C</math> produce una variazione di <math>E</math>. | |||

Non possiamo mai riuscire a stabilire relazioni di causa-effetto a livello teorico, possiamo farlo solo a livello empirico. | |||

Se osserviamo empiricamente, sulla base dei dati, che una variazione di <math>C</math> e regolarmente seguita da una variazione di <math>E</math>, | |||

possiamo dire che c'è un elemento di conferma empirica di un'ipotesi causale. Occorre distinguere tra il livello teorico e il livello causale, che è il livello empirico che può essere affrontato solo attraverso lo studio delle covariazioni. | |||

In altre parole, se osserviamo che una variazione di <math>C</math> e regolarmente seguita da una variazione di<math>E</math>, c'è un elemento di corroborazione, ma ogni altra possibile causa deve ancora essere eliminata. Empiricamente, il compito è quello di dire che vogliamo trovare una covariata, ma poiché c'è la multicausalità, come possiamo assicurarci che questa covariata esista realmente e affermare che abbiamo un elemento di corroborazione empirica dell'assunzione del rapporto di causa-effetto? | |||

== Corrosione empirica di una relazione causale == | |||

Se osserviamo empiricamente che una variazione di <math>X</math> è regolarmente seguita da una variazione di <math>Y</math> mantenendo costanti tutti gli altri. <math>X</math> (altre cause e fattori esplicativi) esiste un forte elemento di corroborazione scientifica dell'ipotesi che <math>X</math> o la causa di <math>Y</math>. | |||

Nella ricerca empirica non potremmo mai parlare di causa ed effetto; dobbiamo tenere presente che il rapporto di causa-effetto rimane nell'ambito della teoria, empiricamente possiamo avvicinarci solo in certe condizioni, trovando la covarianza e mantenendo costanti gli altri fattori. | |||

# covarianza tra variabili dipendenti (dipende) e indipendenti (causa, non dipende da nient'altro): entrambe devono variare. | |||

# direzione causale: è necessario dare una direzione alla causalità, il problema dell'endogeneità. | |||

# Impossibilità logica: se si ha una teoria della classe sociale che influenza l'orientamento politico, è ovvio che è la classe che determina. La causalità non può essere invertita. | |||

Va ricordato che nelle scienze sociali vogliamo muoverci verso un'idea di spiegazione causale. Tuttavia, questo non può mai essere fatto, perché sul piano epistemologico l'idea di causa ed effetto è a livello teorico. A livello empirico, possiamo parlare solo di "variazione", ma in certe condizioni possiamo confermare, cioè verificare empiricamente una relazione causale. | |||

= Corrosione empirica di una relazione causale = | |||

Ci sono tre condizioni da soddisfare per verificare empiricamente una relazione causale. | |||

== Covariazione tra variabili indipendenti e dipendenti == | |||

*variazione della variabile indipendente: questa è la causa (<math>X</math>) ex: istruzione | |||

*variazione della variabile dipendente: dipende da <math>X</math>, è l'effetto; per esempio, la partecipazione - quello che si suppone che tu debba spiegare deve variare! Anche la variabile indipendente! | |||

Al massimo, la relazione causale teorica può essere corroborata empiricamente. | |||

== Direzione causale == | |||

"Non posso dire se questo e <math>X</math> che determina l'attributo <math>Y</math> o il contrario". Ci sono tre modi per determinare la direzione causale e per avvicinarsi all'ideale teorico per definire una relazione causa-effetto. | |||

*manipolazione della variabile indipendente: analisi sperimentale, questi sono diversi metodi scientifici fondamentali. | |||

*successione temporale: ci sono alcune variabili che logicamente precedono altre variabili. Ad esempio, la socializzazione primaria precede (influenza) il comportamento di voto di una persona che ha 30 anni. (in questo caso il problema dell'endogeneità è risolto). In alcuni casi ci sono successioni ovvie. A livello empirico questo è importante per determinare una direzione verso la causalità. | |||

*impossibilità logica: la classe sociale non determina l'orientamento politico. Ci sono alcuni fattori che non possono dipendere da altri fattori. Ci sono impossibilità logiche che rendono possibile stabilire il rapporto di causa-effetto. | |||

== Controllo di variabili esterne == | |||

Dal punto di vista empirico, si potrebbe dire che il livello di partecipazione politica varia a seconda di diverse variabili. Questo è lo scopo del controllo delle variabili esterne. Si può dire che il 90 per cento di ciò che facciamo nella ricerca nel campo delle scienze sociali è garantire che possiamo controllare l'effetto di fattori esplicativi che non ci interessano. Elemento determinante: controllo delle altre variabili. | |||

*applicazione della regola "ceteris paribus": il rapporto di causa-effetto può essere determinato sapendo che il resto non è coinvolto, a parità di tutte le altre cose. C'è una relazione tra un dato fenomeno e un altro fenomeno, a parità di tutte le altre cose, cioè dobbiamo fare in modo che tutti gli altri fattori si possano dire controllati o, in altre parole, resi costanti. | |||

*dipende dalla logica del design della ricerca: è il mio modo di controllare il ruolo di altre potenziali cause che dipendono dal design del modello di ricerca. Dipende dalla logica del design di ricerca; design di ricerca osservazionale. Il modo di aggirare questo problema è diverso a seconda del modello di ricerca. L'obiettivo è quello di controllare l'effetto di altre cause potenziali di cui vogliamo mostrare l'effetto. | |||

= Falsa relazione causale = | |||

== Definizione == | |||

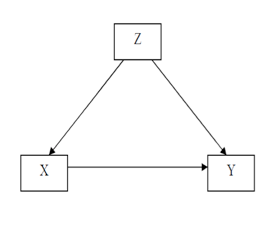

Falsa relazione causale (spiriosa): è una relazione causale apparente, ma inesistente, pensavamo di aver trovato una relazione causale, ma alla fine non c'erano relazioni causali, ma solo una covariata. È una covariata tra due variabili (<math>X</math> ; <math>Y</math>) che non risulta da un nesso causale tra <math>X</math> e <math>Y</math>, ma dipende dal fatto che <math>X</math> e <math>Y</math> sono influenzati da una terza variabile <math>Z</math>. La variazione di <math>Z</math> produce la variazione simultanea di <math>X</math> e <math>Y</math> senza che ci sia una relazione causale tra i due. | |||

C'è sempre il pericolo che una relazione osservata possa non essere indicativa di una relazione causale.[[Fichier:Relation causale fallacieuse (spirious).png|700px|vignette|centré|Assumiamo una relazione causale tra <math>X</math> e <math>Y</math>, ma non e' vero. Il rapporto tra X e Y è fuorviante. C'è una sola covariata, le variabili di controllo devono essere introdotte.]] | |||

== Esempio di relazione causale ingannevole == | |||

=== Esempio 1 === | |||

L'intenzione di voto è influenzata da diversi fattori (età, sesso, istruzione, classe sociale, orientamento politico della famiglia, ecc. | |||

Possiamo trovare un collegamento tra l'istruzione (<math>X</math>) e votare (<math>Y</math>), ma alla fine è la classe sociale (<math>Z</math>) che li determina entrambi. Pertanto, le variabili di controllo devono essere introdotte! Altrimenti può essere solo una covariata senza nesso causale. | |||

Uso della televisione da parte di due candidati (<math>X</math>) | |||

nelle elezioni presidenziali per comunicare il loro programma. | |||

Vogliamo spiegare il voto (<math>Y</math>), ma il voto è influenzato da diversi fattori che giocano un ruolo come l'istruzione, ma è la classe sociale che genera multicausalità. L'idea è di vedere l'effetto dell'esposizione alla campagna televisiva sugli elettori. Quindi c'è una relazione molto forte tra <math>X</math> et <math>Y</math>. Possiamo fidarci della covarianza tra <math>X</math> e <math>Y</math> ? | |||

Gli elettori che hanno seguito la campagna in televisione (<math>X</math>) ha votato in numero maggiore per uno dei due candidati (<math>Y</math>). Si potrebbe dire che l'esposizione alla campagna produce il voto, ma si dovrebbe tener conto di quanto segue: elettori più anziani (<math>Z</math>) guardare la televisione più spesso, quindi l'età influenza il voto (vecchio a destra, giovane a sinistra). | |||

L'età (Z) influenza sia l'esposizione alla campagna in televisione (<math>X</math>), i più anziani rimangono a casa, guardano la TV e votano per uno dei due candidati (<math>Y</math>). | |||

Così, la covarianza tra <math>X</math> e <math>Y</math> non è verificata, perché la variabile <math>Z</math> | |||

influenza le altre due variabili contemporaneamente. A tal fine è necessario introdurre una variabile di controllo. | |||

Esamineremo i fattori che spiegano in modo plausibile ciò che vogliamo spiegare. | |||

=== Esempio 2 === | |||

Ad esempio, se siamo interessati al numero di frigoriferi e al livello di democrazia, affermare un legame tra i due è irrilevante. Tuttavia, si potrebbe spiegare che una terza variabile, che sarebbe il grado di urbanizzazione, genera democrazia secondo certe teorie e allo stesso tempo aumenta il numero di frigoriferi. Quindi la covariata non è una relazione di causa-effetto, perché c'è una terza variabile che influenza sia l'una che l'altra ed è una relazione di causa-effetto. | |||

=== Esempio 3 === | |||

Se la partecipazione politica (<math>Y</math>) si spiega con l'impegno associativo (<math>X</math>) si potrebbe pensare che questo rapporto sia reso fallace dal fatto che esiste un'altra variabile che influenza sia la partecipazione che l'impegno associativo. Questa variabile (<math>Z</math>) potrebbe essere la partecipazione politica. Anche in questo caso, c'è una relazione fuorviante; sarebbe un errore concludere dalla semplice osservazione di questa relazione che esiste una relazione causale tra<math>X</math> y <math>Y</math> perché l'effetto di un'altra variabile non è stato controllato. | |||

= Due modi per controllare empiricamente un'affermazione causale = | |||

Nel caso di problemi legati a relazioni causali fuorvianti (multicausalità ed endogeneità), ci sono due modi per controllare empiricamente l'affermazione causale. | |||

== | == Analisi della covarianza (dati di osservazione) == | ||

*'''controllo''': trasformazione di variabili esterne (<math>Z</math>) in costanti, quindi non ha effetti, perché non c'è covarianza, non cambia. Dobbiamo prendere in considerazione le possibilità di relazioni ingannevoli (ad esempio, guardiamo tra tutti coloro che frequentano l'università nella classe sociale più alta, e poi analizziamo il loro voto; quindi la classe non avrà un ruolo nell'analisi). Questo controllo può essere fatto manualmente. | |||

*'''depurazione''': controllo statistico. Facciamo un modello statistico, introduciamo che la variabile <math>X</math>, ci interessa, introduciamo variabili con una forte relazione, poi introduciamo le altre variabili di controllo, e se troviamo ancora un effetto tra <math>X</math> e <math>Y</math>, significa che il rapporto non era fuorviante. Questo viene fatto da un computer che calcola le relazioni tra tutte le variabili e considera anche tutte le relazioni di co-variazione. Alla fine determina se c'è una falsa correlazione o meno. Il controllo statistico è un modo di controllare le variabili e permette di verificare empiricamente la relazione causa-effetto. | |||

Il | |||

= | == Esperimento (dati sperimentali) == | ||

Il | E' l'implementazione di un metodo sperimentale. Nell'analisi della covarianza agiamo una volta che abbiamo i dati, cioè manipoliamo i dati a priori dal disegno di ricerca, mentre nel metodo sperimentale agiamo prima (come produciamo i dati?). Il metodo sperimentale è utilizzato per evitare una relazione fuorviante, un campione è diviso in due gruppi e gli individui sono selezionati in modo casuale. Secondo la legge dei grandi numeri, si può dimostrare che i due gruppi sono simili, quindi l'unica differenza sarà la variabile indipendente. | ||

'''Conclusione''': è una riflessione sulla causalità; è stato detto che la questione della causalità rimane a livello teorico, possiamo solo cercare di avvicinarci a questo ideale. Bisogna cercare una correlazione, ma bisogna escludere ipotesi (contro variabili), se non lo si fa si può cadere in una relazione causale fuorviante. | |||

'''Covariazione''': può essere vicino a una relazione causale, ma è l'effetto di un <math>Z</math> | |||

(variabile non osservata) che influenza ciò che vogliamo spiegare (dipendente) e ciò che spiegherebbe ciò che vogliamo spiegare (indipendente). Una variabile influenza le altre due variabili contemporaneamente, vi è anche la possibilità di un'interazione tra variabili esplicative. | |||

Come controllare le variabili per evitare di cadere in una relazione ingannevole? Ci sono due modi: | |||

*'''analisi di covarianza''': osserviamo (dati osservazionali) dopo averli avuti. | |||

**'''controllo''': faremo costante una variabile straniera, quando abbiamo un rapporto presunto tra due variabili che viene reso fallace, perché c'è una terza variabile, prendiamo una parte degli individui che corrisponde alla seconda variabile, ad esempio, prendiamo persone della stessa età, per il rapporto comportamentale tra esposizione televisiva e voto. Così abbiamo controllato questo valore, l'abbiamo reso costante. | |||

*'''depurazione''': è un controllo statistico. Depurazione per tutte le variabili. | |||

**'''analisi sperimentale''': abbiamo messo a punto un disegno di ricerca che evita l'esistenza di variabili Z che potrebbero influenzare la nostra analisi. | |||

= | = Quattro metodi scientifici fondamentali secondo Arend Lipjhart = | ||

Si possono menzionare tre o addirittura quattro metodi: | |||

#Metodo sperimentale (si differenzia dagli altri) | |||

#Metodo statistico | |||

#Metodo comparativo | |||

#Caso di studio | |||

Questi sono i tre metodi fondamentali che permettono di controllare le variabili note anche come "fattori esplicativi aggiuntivi". L'obiettivo è quello di verificare le ipotesi ed escluderne alcune in concorrenza con altre. | |||

I primi tre metodi, infine, hanno tutti l'obiettivo principale di ricercare rapporti di causa-effetto e di eliminare il rumore prodotto da <math>Z</math> che potrebbero produrre un rapporto fuorviante, hanno lo stesso scopo, ma lo perseguono in modo diverso. I tre stabiliscono proposizioni empiriche generali sotto il controllo di tutte le altre variabili (<math>Z</math>). Vogliono avvicinarsi al rapporto teorico causa-effetto tra un fenomeno osservato e le cause potenziali, ci sono diversi gradi di successo, abbiamo visto che il metodo sperimentale e quello più vicino ad esso, sui diversi fattori esplicativi. L'idea è di arrivare ad una conferma empirica delle affermazioni causali. | |||

== | == Metodo sperimentale == | ||

=== | === Principi === | ||

*'''Assegnazione casuale''': selezionati a caso, tutti gli individui hanno le stesse probabilità di essere nel gruppo di controllo sperimentale o soggetto (nei gruppi di controllo sperimentale e non sperimentale). Questa idea è nata dal principio della legge dei grandi numeri: la variabile casuale dovrebbe escludere qualsiasi altra spiegazione. | |||

*'''Manipolazione della variabile indipendente''' (trattamento), come sono uguali i gruppi? Il ricercatore, ad un certo punto, introduce un input in uno dei due gruppi. | |||

Separiamo due gruppi in modo che i due gruppi siano gli stessi su tutte le dimensioni tranne che su una che è quella su cui vogliamo testare l'effetto. La selezione di una persona e l'assegnazione casuale rende i due gruppi simili. Se, successivamente, viene introdotto un trattamento in uno dei due gruppi e si osserva un cambiamento che non è nel gruppo di controllo, ci può essere un effetto causale che va in una riflessione di causa ed effetto. Si può pertanto concludere che la variabile introdotta ha un effetto causale. | |||

=== Tipi di esperimenti === | |||

*In '''laboratorio''' (laboratory experiment): si tratta di esperimenti eseguiti in laboratorio e poi gli individui vengono divisi in gruppi ai quali vengono applicati stimoli per arrivare ad un riscontro di effetto o non effetto. Tuttavia, gli individui vengono prelevati dalle loro condizioni naturali che possono portare a risultati che sono legati all'artificialità delle condizioni sperimentali. | |||

*'''Esperimento sul campo''' (field experiment): contesto naturale, possono essere coinvolti altri fattori. Si tratta di esperimenti che sono stati applicati nelle scienze politiche. I principi rimangono gli stessi con una distribuzione casuale dei soggetti in due gruppi; la variabile indipendente viene manipolata e poi si determina se c'è stato un effetto del trattamento sul gruppo sperimentale e non sul gruppo di controllo. In questo modo è possibile evitare di criticare l'artificialità degli esperimenti di laboratorio. | |||

*'''Disegno quasi-sperimentale''' (quasi-experiment): questo disegno tiene presente che il ricercatore manipola la variabile indipendente, ma non ci sono allocazioni casuali di soggetti ad un gruppo sperimentale e ad un gruppo di controllo. Se lo facciamo, è perché non possiamo distribuirci a caso in due gruppi, siamo costretti a prendere i gruppi effettivamente esistenti. In altre parole, il ricercatore controlla il trattamento, ma non può assegnare i soggetti in modo casuale. A volte, quando siamo sul campo, è difficile fare le cose in modo diverso. Di solito questo è il metodo che usiamo, perché c'è un fattore che non possiamo controllare. | |||

=== Esempio === | |||

Uno psicosociologo ha voluto testare gli effetti degli obiettivi collettivi sulle relazioni interpersonali. Voleva vedere fino a che punto, quando a un gruppo di persone viene detto che c'è un obiettivo, stereotipi negativi in conflitto scompaiono. È un'esperienza immediata in condizioni naturali. Ha lasciato che i bambini interagissero tra loro, i bambini collaborano tra loro; il ricercatore ha cercato di creare un'identità collettiva e ha diviso il gruppo in due in modo casuale. Li ha fatti giocare a calcio; abbiamo visto emergere rivalità e persino stereotipi negativi nei confronti dell'altra squadra. Poi ha rimesso insieme il gruppo e ha ridefinito un obiettivo comune che richiede cooperazione. In seguito, ha notato che questi conflitti, gli stereotipi negativi e le ostilità si sono trasformati in una vera e propria cooperazione. | |||

== Metodo statistico == | |||

Non possiamo fare un disegno di ricerca che a priori ci permette di verificare se ci sono relazioni di correlazione, ma dobbiamo farlo dopo il fatto. | |||

*'''manipolazione concettuale (matematica) di dati empiricamente osservati''': abbiamo dati osservazionali o cerchiamo di controllare per controllo statistico, con correlazioni parziali. Si distingue tra dati sperimentali e osservazionali. | |||

*'''correlazioni parziali''': correlazione tra due variabili una volta lasciata l'analisi, cioè il controllo dell'effetto di altre variabili che potrebbero influenzare ciò che si vuole spiegare. In altre parole, significa fare le altre Z come se fossero costanti a seguito di un processo di depurazione. E' una logica di controllo delle variabili: controlliamo le variabili che possono influenzare ciò che vorremmo spiegare. Nell'esempio sul voto, dovrebbe essere preso in considerazione tutto ciò che potrebbe spiegare il voto, soprattutto se si può presumere che questo fattore esterno possa influenzare sia il voto che la variabile indipendente (esposizione mediatica). In questo modo possiamo sapere se ci stiamo avvicinando a un effetto causale. Tradotto con www.DeepL.com/Translator | |||

L'importante è andare oltre la semplice analisi bivariata; è necessario passare ad un'analisi multivariata dove altre variabili sono introdotte nel modello esplicativo. | |||

== | == Metodo comparativo == | ||

Tutta la ricerca nel campo delle scienze sociali è per sua natura comparativa. Confrontiamo sempre qualcosa in modo implicito o esplicito. Ci si può chiedere quali siano gli obiettivi del confronto. Abbiamo visto che gli obiettivi di qualsiasi metodo scientifico cercano di stabilire proposizioni empiriche generali controllando tutte le altre variabili, ma secondo alcune, come Tilly, ci sono quattro obiettivi per il confronto, cioè il confronto delle unità di osservazione. | |||

Gli obiettivi del confronto secondo Charles Tilly sono: | |||

*'''Individualizzazione (individualizing)''': l'obiettivo è quello di evidenziare ed evidenziare le caratteristiche di una data unità di analisi su un certo fenomeno; l'idea è quella di trovare confronti, di dare specificità ad un dato caso di esempio; negli studi di politica comparativa, il caso è il paese, i paesi sono confrontati; l'obiettivo è, ad esempio, di mostrare alcune caratteristiche del sistema politico svizzero rispetto ad altri paesi. La democrazia diretta determina i valori politici; la democrazia diretta svizzera può essere confrontata con paesi che non ne dispongono. Possiamo analizzare l'impatto di questa caratteristica sulle persone. Caratterizzare, individualizzare, personalizzare, rendere più specifiche le caratteristiche di un paese rispetto ad un altro. | |||

*'''Generalizzare (generalizing)''' : non confrontiamo per individualizzare, ma per generalizzare, includiamo il maggior numero di casi, stabiliamo proposte empiriche generali. Per alcuni, la generalizzazione è uno dei due obiettivi principali del metodo comparativo. Studiamo i comportamenti che confrontiamo, vogliamo vedere se le configurazioni e gli effetti che troviamo in un contesto si trovano in un altro contesto. | |||

*'''Ricerca di variazioni sistematiche (variation finding)''': l'obiettivo è quello di cercare variazioni sistematiche e testare una teoria scartando le teorie concorrenti da quella che si vuole evidenziare. Secondo Tilly, questo è il modo migliore per fare un confronto. Cerchiamo di testare un'ipotesi causale, quindi escludiamo ipotesi rivali. | |||

*'''Globalizzazione (encompassing)''': l'obiettivo è quello di globalizzare (approccio sistemico) che comprende tutti i paesi del mondo, o tutte le possibili unità di confronto. L'idea è che se si rimuove una di queste unità di confronto, l'intero sistema cambia. Per il professor Giugni, questo non è un approccio comparativo, perché non c'è confronto. | |||

Ci sono diversi obiettivi del confronto; agire sulla selezione dei casi è comparare. | |||

Strategie di confronto per cercare variazioni sistematiche (Przeworski e Teune) Si può fare una distinzione tra due strategie di confronto, sono logiche e modi di procedere metodologicamente nella scelta dei casi. Questi sono modi per affrontare la questione della causalità quando sono disponibili dati osservazionali. Viene fatta una distinzione tra due progetti di ricerca comparativa, vale a dire il confronto per caso analogico (simile) e per contro caso (diverso). Ciascuna delle opzioni presenta vantaggi e svantaggi. | |||

*'''Confronto tra casi contrastanti (la maggior parte dei sistemi di progettazione diversi)''': scegliamo casi che sono i più diversi possibili | |||

*'''Confronto tra casi analoghi (progettazione di sistemi più simili)''': ha lo scopo di controllare tutte le variabili tranne quella che si vuole analizzare (esempio Francia - Svizzera). | |||

[[Fichier:Two designs for macro-analytic comparative history (from Stuart Mill).png|700px|vignette|centré|Skocpol, T. et M. Somers (1994). “The Uses of Comparative History in Macrosocial Inquiry”. In Theda Skocpol (éd.), Social Revolutions in the Modern World. Cambridge: Cambridge University Press. ]]Stuart Mill ha riflettuto su come analizzare questo nesso causale. Selezionando diversi casi per raggiungere questo ideale, puntiamo al rapporto di causa-effetto. Ma non siamo nel contesto del controllo statistico. Nel nostro caso, attraverso la selezione dei casi, cerchiamo di avvicinarci a questo ideale. | |||

Stuart Mill distingue tra due casi: | |||

*'''The method of agreement''' (the most different system design): la logica è quella di scegliere paesi molto diversi, ma che sono simili su un fattore chiave. C'è una X ovunque. Poi osserviamo Y, poi c'è una somiglianza nella variabile Y che vogliamo spiegare. La logica è quella di dire che stiamo cercando paesi dove troviamo lo stesso fenomeno, che è quello di cui vogliamo dimostrare l'effetto. Osserviamo quello che succede è che ogni volta che c'è la X troviamo la Y. In quel momento, è prodotto da X perché non può essere prodotto da nient'altro, perché gli altri fattori dei paesi sono diversi, non si trova da nessun'altra parte. La logica è quella di scegliere casi molto diversi sulla maggior parte dei fattori a cui si può pensare e poi si vedrà se c'è una compresenza della variabile che si vuole spiegare e di quella che spiega. | |||

' | |||

*'''The method of difference''' (the most similar system design): stiamo cercando paesi che sono il piu' simili possibile. Si può operare una distinzione tra casi positivi e negativi. Cercheremo i casi che hanno il fattore A, B e C e i casi negativi che hanno anche A, B e C. Nei casi positivi è presente un fattore che non è presente nei casi negativi. Quindi la votazione è presente quando X è presente e assente quando X è assente. La conclusione è che X è la causa dell'effetto Y, perché la presenza di almeno Y non può essere stata prodotta da A, B e C. Abbiamo reso costanti A, B e C. | |||

*''' | Esempio - la maggior parte della progettazione del sistema: ci sono tre casi (1, 2, n); un caso può essere individuale, nazionale, ecc. Abbiamo una serie di qualità per questi casi. Queste sono caratteristiche dei diversi paesi (disoccupazione, sviluppo), X è la variabile indipendente e vogliamo spiegare Y. In questa logica di confronto, i casi sono molto diversi, ma sono simili in una sola proprietà. Quindi questa variabile spiega il fattore, perché è l'unico fattore comune. Nella Tabella 2 abbiamo casi positivi e negativi; questi casi sono perfettamente simili su quanti più attributi, proprietà e variabili possibili, ma c'è una differenza cruciale in ciò che si suppone di spiegare ciò che vogliamo spiegare. C'è un fattore che non è presente. In un caso c'è Y nell'altro passaggio; la differenza è attribuita alla variabile che non lo è in entrambi i casi. Questo metodo cerca di approssimare l'approccio sperimentale, perché è fatto in modo che i due gruppi siano il più possibile vicini (simili ad a, b, c), ma differiscono dalla variabile indipendente, più simile al disegno del sistema. Il professor Giugni preferisce questo modo, perché si avvicina all'ideale di sperimentazione. Un esempio è quello di studiare gli studenti che frequentano il corso nell'arco di due anni e cambiano le diapositive che vengono fornite. Poi, confrontiamo il risultato finale (il punteggio medio) in entrambi i casi. | ||

Esempio - sistema più simile: confronto paesi simili (Francia e Svizzera), e voglio dimostrare che la repressione della polizia francese è più forte, è l'unico fattore che differisce da un paese all'altro. Poi vediamo che la radicalizzazione dei movimenti sociali è più forte in Francia. Il problema è che la "A", cioè i fattori che sono simili tra i due paesi, non sono mai uguali, ma solo simili (questo problema può essere trovato solo con il metodo di progettazione di ricerca più simile, motivo per cui ci sono ricercatori che preferiscono l'altro approccio, in cui è solo necessario trovare le differenze), possiamo solo avvicinarci all'ideale. Inoltre, troviamo il problema dell'endogeneità, cioè sapere quale fattore influenza l'altro. | |||

== | == Caso di studio == | ||

È un metodo più qualitativo, si differenzia dagli altri tre metodi in quanto sono più orientati alla ricerca quantitativa-positivista. Ci sono alcune distinzioni fatte da Arend Lipihart, c'è una sorta di scissione, una distinzione tra dati sperimentali e d'altra parte i dati di osservazione. | |||

Mentre il metodo sperimentale si basa sull'idea di un gran numero, il metodo comparativo un numero di casi che possono variare, il caso studio si basa su un solo caso. Tuttavia, è possibile prendere in considerazione un caso di studio che può coprire più di un caso, in quanto il confine è a volte flessibile. | |||

Il caso di studio è solo lo studio di un caso, non ha alcun confronto. Un caso può essere costituito da molte cose come una festa, una persona o un paese. Cerchiamo di studiare un caso particolare in modo approfondito, ma non in modo estensivo come gli altri tre metodi che non studiano i casi in modo così approfondito. | |||

In altre parole, il grande vantaggio del caso di studio è che si può andare molto più a fondo nella conoscenza del caso. Uno studio di caso è per definizione intensivo, mentre lo studio quantitativo è ampio. Un metodo si basa su standard con l'idea di generalizzare mentre l'altro si basa su un'interpretazione approfondita di un caso specifico. | |||

Se il metodo statistico mira a generalizzare, il caso studio per definizione non consente la generalizzazione, l'obiettivo è un altro. Esistono diversi studi di caso e diversi modi di condurre un caso studio. Possiamo citare 6 varianti: | |||

* i primi due dei quali sono destinati a concentrarsi sul caso specifico. | |||

* le altre quattro modalità hanno l'obiettivo di creare o generare una teoria. | |||

Il caso studio può essere utilizzato per raggiungere diversi obiettivi, da un lato si vuole conoscere meglio una particolare situazione in modo descrittivo, dall'altro si possono studiare diversi casi che permettono di generare una teoria a lungo termine. | |||

* | |||

*' | |||

Secondo Arend Lipihart, lo scopo della ricerca è quello di testare e verificare una teoria e di generalizzare i risultati. | |||

Questi due casi non vogliono creare ipotesi, l'idea è quella di far luce su qualcosa in relazione a un caso: | |||

*'''ateorico''': non c'è teoria, è puramente descrittivo. Si tratta di ricerca esplorativa, ad esempio, lo studio di una nuova organizzazione, vogliamo solo conoscerla e descriverla, nel qual caso non possiamo generalizzare i risultati, perché sono legati ad un caso particolare studiato. Viene utilizzato in situazioni o casi che non sono mai stati studiati prima. | |||

*'''interpretativo''': usiamo proposte teoriche che esistono in letteratura, in questo approccio qualitativo il ruolo della letteratura è meno importante, applichiamo una generalizzazione esistente ad un caso dato, qui il caso riguarda un caso specifico, senza la volontà di creare una teoria proprio come l'ateo. L'obiettivo non è di confermarlo o negarlo, ma solo di applicarlo. Le proposte o teorie esistenti sono utilizzate e applicate ad un caso; le generalizzazioni esistenti sono applicate ad esso per vedere se la generalizzazione è basata su quel caso specifico. Una situazione particolare viene interpretata alla luce di una teoria esistente. | |||

* | |||

*''' | |||

I prossimi quattro vogliono creare una teoria o trarre qualcosa dai casi. Il loro obiettivo è quello di creare o generare teorie o ipotesi: | |||

*''' | *'''generare ipotesi''': vogliamo creare ipotesi dove non ce ne sono. Studio un caso non solo perché mi interessa, ma perché voglio formulare ipotesi che proverò altrove. Ad esempio: un'organizzazione che si occupa di politica. Studiamo una data situazione perché vogliamo ipotesi che non possiamo trovare altrove. Si esplora un caso per formulare ipotesi. Le ipotesi hanno essenzialmente tre fonti: letteratura esistente, immaginazione sociologica, studi esplorativi. | ||

*''' | *'''confermando una teoria''': testando una teoria su un caso particolare per confermare questa teoria, questo tipo di studio di caso non è molto utile, perché non è il fatto che c'è un caso che riflette una teoria esistente che rafforzerà la teoria che rende questo sistema poco utile. | ||

*''' | *'''invalidare una teoria''': questo è molto più prezioso, c'è una teoria che viene applicata in un caso specifico, non cerchiamo di confermare la teoria, ma per dimostrare che non funziona, cerchiamo di invalidare una teoria. Questo ci porta a pensare alla teoria, è qualcosa di importante per sviluppare una teoria. | ||

*''' | *'''caso deviante''': perché un caso si discosta dalla generalizzazione, questo caso è molto utile quando si vuole confutare una teoria. Stiamo cercando una situazione che si discosta da una situazione esistente, il caso studio cerca di mostrare perché questo caso si discosta dalla generalizzazione. | ||

= | = Allegati = | ||

*[http://www.nyu.edu/gsas/dept/politics/faculty/wood/wood_home.html Elisabeth Wood] - An Insurgent Path to Democracy: Popular Mobilization, Economic Interests and Regime Transition in South Africa and El Salvador," Comparative Political Studies, October 2001. Translation published in Estudios Centroamericános, No. 641-2, 2002. url: http://cps.sagepub.com/content/34/8/862.short | *[http://www.nyu.edu/gsas/dept/politics/faculty/wood/wood_home.html Elisabeth Wood] - An Insurgent Path to Democracy: Popular Mobilization, Economic Interests and Regime Transition in South Africa and El Salvador," Comparative Political Studies, October 2001. Translation published in Estudios Centroamericános, No. 641-2, 2002. url: http://cps.sagepub.com/content/34/8/862.short | ||

= | = Riferimenti = | ||

<references /> | <references /> | ||

Version actuelle datée du 15 février 2019 à 00:59

| Faculté | Faculté des sciences de la société |

|---|---|

| Département | Département de science politique et relations internationales |

| Professeur(s) | Marco Giugni[1] |

| Cours | Introduzione ai metodi della scienza politica |

Lectures

Sfide all'inferenza empirica nelle scienze politiche[modifier | modifier le wikicode]

Definizione[modifier | modifier le wikicode]

- inferire: trarre conclusioni generali da fatti, dati osservazionali e dati sperimentali. Un contesto di inferenza empirica esiste quando si vogliono stabilire legami e relazioni tra fattori esplicativi e spiegare sulla base di dati concreti o empirici.

- causalità: Come giudicare le relazioni causa-effetto è una questione centrale, specialmente nella metodologia.

- empirico: trarre conclusioni generali da prove empiriche.

Le tre sfide[modifier | modifier le wikicode]

Multi-causalità[modifier | modifier le wikicode]

- presque tout à un impact : c'est déterminé par une multiplicité de causes possibles ; ex, le comportement de vote politique n'est pas déterminé par une cause, il y a plusieurs facteurs. Un exemple est le niveau d'éducation, mais il y a d‘autres facteurs contextuels qui interviennent : sexe, position dans les classes.

- chaque phénomène a plusieurs causes : on peut difficilement défendre une position qui dit qu’un phénomène donné n’a qu’une seule cause. Lorsqu’il y a plusieurs facteurs, cela complique la tâche.

Condizionalità del contesto[modifier | modifier le wikicode]

Collegato al benchmarking; esiste un canale istituzionale che permette ai cittadini di partecipare, il che aiuta a spiegare perché le persone partecipano in Svizzera, ma non in altri paesi dove non esiste una democrazia diretta. Le cause di un fenomeno possono variare da un contesto all'altro. Il legame tra classe e voto dimostra che c'è condizionalità nel contesto e modifica il rapporto che può esistere tra due fattori che possono essere studiati. Ci sono effetti variabili nel contesto.

- L'effetto di quasi tutto dipende da quasi tutto il resto.

- Gli effetti di ciascuna causa tendono a variare da un contesto all'altro.

Endogeneità[modifier | modifier le wikicode]

Cause ed effetti si influenzano a vicenda; questo è il problema maggiore negli studi empirici, specialmente quelli che seguono l'approccio dell'osservazione. Ad esempio: l'interesse politico influenza la partecipazione (forte correlazione tra interesse (indipendente) e partecipazione (dipendente)). Il problema è che la causalità può essere invertita: "ciò che voglio spiegare può spiegare ciò che si suppone spieghi ciò che volevo spiegare".

È la difficoltà di distinguere tra "ciò che voglio spiegare" e il fattore che spiega questo fenomeno. La causa diventa un effetto e viceversa.

- Quasi tutto causa quasi tutto il resto.

- Cause ed effetti si influenzano a vicenda.

Spesso è difficile dire in quale direzione vada la causalità che si vuole applicare.

Il concetto di causa[modifier | modifier le wikicode]

Determinazione del rapporto di causalità[modifier | modifier le wikicode]

Nell'approccio scientifico delle scienze sociali, l'obiettivo è quello di determinare le relazioni causali.

"Se C (causa), allora E (effetto).[modifier | modifier le wikicode]

Non e' abbastanza! Il rapporto tra C ed E può a volte o sempre essere utile. Esempio - Dobbiamo essere un po' più specifici. Se diciamo che se c'è un alto livello di istruzione, possiamo dire che c'è un livello di partecipazione più elevato. Si sostiene che se c'è C allora c'è E, non c'è univocità del rapporto mentre il rapporto di causa ed effetto deve essere univoco.

"Se C, allora (e solo allora) sempre E.[modifier | modifier le wikicode]

In questo caso ci sono le quattro caratteristiche della relazione causa-effetto:

- Condizionalità: effetto a condizione che vi sia una causa.

- Successione: prima la causa, poi l'effetto.

- Coerenza: "Sempre" ogni volta che la causa è presente, si osserva anche l'effetto.

- Univocità: il legame è unico.

Vengono introdotti elementi importanti per definire che cos'è una causa. - non è ancora abbastanza! Esempio: se il livello di istruzione è alto, allora e solo allora c'è sempre una maggiore partecipazione.

Tuttavia, secondo alcuni, nell'epistemologia della scienza, manca l'elemento che consiste nel dire che ci deve essere un legame genetico, un legame nella produzione dell'effetto dovuto alla causa.

"Se C, allora (e solo allora) E sempre prodotto da C".[modifier | modifier le wikicode]

VERO: Un dato effetto non solo deve essere correlato ad una causa, ma l'effetto deve essere prodotto e generato da quella causa. La distinzione è più filosofica che sostanziale.

Definizione di cosa sia una causa[modifier | modifier le wikicode]

- è generato da , quindi non basta osservare una covarianza tra una causa ed un effetto, ma è necessario, per parlare di causa, che l'effetto sia generato dalla causa.

- La causa deve produrre l'effetto. (ad esempio, se si ha un alto livello di istruzione, questo genera la partecipazione alla politica).

Fondamentalmente, nel contesto del pensiero causale, appartiene solo al livello teorico. Quando parliamo di causa, siamo su un piano puramente teorico e non empirico. Pertanto, non si può mai dire che empiricamente, una variazione di produce una variazione di .

Non possiamo mai riuscire a stabilire relazioni di causa-effetto a livello teorico, possiamo farlo solo a livello empirico.

Se osserviamo empiricamente, sulla base dei dati, che una variazione di e regolarmente seguita da una variazione di ,

possiamo dire che c'è un elemento di conferma empirica di un'ipotesi causale. Occorre distinguere tra il livello teorico e il livello causale, che è il livello empirico che può essere affrontato solo attraverso lo studio delle covariazioni.

In altre parole, se osserviamo che una variazione di e regolarmente seguita da una variazione di, c'è un elemento di corroborazione, ma ogni altra possibile causa deve ancora essere eliminata. Empiricamente, il compito è quello di dire che vogliamo trovare una covariata, ma poiché c'è la multicausalità, come possiamo assicurarci che questa covariata esista realmente e affermare che abbiamo un elemento di corroborazione empirica dell'assunzione del rapporto di causa-effetto?

Corrosione empirica di una relazione causale[modifier | modifier le wikicode]

Se osserviamo empiricamente che una variazione di è regolarmente seguita da una variazione di mantenendo costanti tutti gli altri. (altre cause e fattori esplicativi) esiste un forte elemento di corroborazione scientifica dell'ipotesi che o la causa di .

Nella ricerca empirica non potremmo mai parlare di causa ed effetto; dobbiamo tenere presente che il rapporto di causa-effetto rimane nell'ambito della teoria, empiricamente possiamo avvicinarci solo in certe condizioni, trovando la covarianza e mantenendo costanti gli altri fattori.

- covarianza tra variabili dipendenti (dipende) e indipendenti (causa, non dipende da nient'altro): entrambe devono variare.

- direzione causale: è necessario dare una direzione alla causalità, il problema dell'endogeneità.

- Impossibilità logica: se si ha una teoria della classe sociale che influenza l'orientamento politico, è ovvio che è la classe che determina. La causalità non può essere invertita.

Va ricordato che nelle scienze sociali vogliamo muoverci verso un'idea di spiegazione causale. Tuttavia, questo non può mai essere fatto, perché sul piano epistemologico l'idea di causa ed effetto è a livello teorico. A livello empirico, possiamo parlare solo di "variazione", ma in certe condizioni possiamo confermare, cioè verificare empiricamente una relazione causale.

Corrosione empirica di una relazione causale[modifier | modifier le wikicode]

Ci sono tre condizioni da soddisfare per verificare empiricamente una relazione causale.

Covariazione tra variabili indipendenti e dipendenti[modifier | modifier le wikicode]

- variazione della variabile indipendente: questa è la causa () ex: istruzione

- variazione della variabile dipendente: dipende da , è l'effetto; per esempio, la partecipazione - quello che si suppone che tu debba spiegare deve variare! Anche la variabile indipendente!

Al massimo, la relazione causale teorica può essere corroborata empiricamente.

Direzione causale[modifier | modifier le wikicode]

"Non posso dire se questo e che determina l'attributo o il contrario". Ci sono tre modi per determinare la direzione causale e per avvicinarsi all'ideale teorico per definire una relazione causa-effetto.

- manipolazione della variabile indipendente: analisi sperimentale, questi sono diversi metodi scientifici fondamentali.

- successione temporale: ci sono alcune variabili che logicamente precedono altre variabili. Ad esempio, la socializzazione primaria precede (influenza) il comportamento di voto di una persona che ha 30 anni. (in questo caso il problema dell'endogeneità è risolto). In alcuni casi ci sono successioni ovvie. A livello empirico questo è importante per determinare una direzione verso la causalità.

- impossibilità logica: la classe sociale non determina l'orientamento politico. Ci sono alcuni fattori che non possono dipendere da altri fattori. Ci sono impossibilità logiche che rendono possibile stabilire il rapporto di causa-effetto.

Controllo di variabili esterne[modifier | modifier le wikicode]

Dal punto di vista empirico, si potrebbe dire che il livello di partecipazione politica varia a seconda di diverse variabili. Questo è lo scopo del controllo delle variabili esterne. Si può dire che il 90 per cento di ciò che facciamo nella ricerca nel campo delle scienze sociali è garantire che possiamo controllare l'effetto di fattori esplicativi che non ci interessano. Elemento determinante: controllo delle altre variabili.

- applicazione della regola "ceteris paribus": il rapporto di causa-effetto può essere determinato sapendo che il resto non è coinvolto, a parità di tutte le altre cose. C'è una relazione tra un dato fenomeno e un altro fenomeno, a parità di tutte le altre cose, cioè dobbiamo fare in modo che tutti gli altri fattori si possano dire controllati o, in altre parole, resi costanti.

- dipende dalla logica del design della ricerca: è il mio modo di controllare il ruolo di altre potenziali cause che dipendono dal design del modello di ricerca. Dipende dalla logica del design di ricerca; design di ricerca osservazionale. Il modo di aggirare questo problema è diverso a seconda del modello di ricerca. L'obiettivo è quello di controllare l'effetto di altre cause potenziali di cui vogliamo mostrare l'effetto.

Falsa relazione causale[modifier | modifier le wikicode]

Definizione[modifier | modifier le wikicode]

Falsa relazione causale (spiriosa): è una relazione causale apparente, ma inesistente, pensavamo di aver trovato una relazione causale, ma alla fine non c'erano relazioni causali, ma solo una covariata. È una covariata tra due variabili ( ; ) che non risulta da un nesso causale tra e , ma dipende dal fatto che e sono influenzati da una terza variabile . La variazione di produce la variazione simultanea di e senza che ci sia una relazione causale tra i due.

C'è sempre il pericolo che una relazione osservata possa non essere indicativa di una relazione causale.

Esempio di relazione causale ingannevole[modifier | modifier le wikicode]

Esempio 1[modifier | modifier le wikicode]

L'intenzione di voto è influenzata da diversi fattori (età, sesso, istruzione, classe sociale, orientamento politico della famiglia, ecc.

Possiamo trovare un collegamento tra l'istruzione () e votare (), ma alla fine è la classe sociale () che li determina entrambi. Pertanto, le variabili di controllo devono essere introdotte! Altrimenti può essere solo una covariata senza nesso causale.

Uso della televisione da parte di due candidati ()

nelle elezioni presidenziali per comunicare il loro programma.

Vogliamo spiegare il voto (), ma il voto è influenzato da diversi fattori che giocano un ruolo come l'istruzione, ma è la classe sociale che genera multicausalità. L'idea è di vedere l'effetto dell'esposizione alla campagna televisiva sugli elettori. Quindi c'è una relazione molto forte tra et . Possiamo fidarci della covarianza tra e ?

Gli elettori che hanno seguito la campagna in televisione () ha votato in numero maggiore per uno dei due candidati (). Si potrebbe dire che l'esposizione alla campagna produce il voto, ma si dovrebbe tener conto di quanto segue: elettori più anziani () guardare la televisione più spesso, quindi l'età influenza il voto (vecchio a destra, giovane a sinistra).

L'età (Z) influenza sia l'esposizione alla campagna in televisione (), i più anziani rimangono a casa, guardano la TV e votano per uno dei due candidati ().

Così, la covarianza tra e non è verificata, perché la variabile

influenza le altre due variabili contemporaneamente. A tal fine è necessario introdurre una variabile di controllo.

Esamineremo i fattori che spiegano in modo plausibile ciò che vogliamo spiegare.

Esempio 2[modifier | modifier le wikicode]

Ad esempio, se siamo interessati al numero di frigoriferi e al livello di democrazia, affermare un legame tra i due è irrilevante. Tuttavia, si potrebbe spiegare che una terza variabile, che sarebbe il grado di urbanizzazione, genera democrazia secondo certe teorie e allo stesso tempo aumenta il numero di frigoriferi. Quindi la covariata non è una relazione di causa-effetto, perché c'è una terza variabile che influenza sia l'una che l'altra ed è una relazione di causa-effetto.

Esempio 3[modifier | modifier le wikicode]

Se la partecipazione politica () si spiega con l'impegno associativo () si potrebbe pensare che questo rapporto sia reso fallace dal fatto che esiste un'altra variabile che influenza sia la partecipazione che l'impegno associativo. Questa variabile () potrebbe essere la partecipazione politica. Anche in questo caso, c'è una relazione fuorviante; sarebbe un errore concludere dalla semplice osservazione di questa relazione che esiste una relazione causale tra y perché l'effetto di un'altra variabile non è stato controllato.

Due modi per controllare empiricamente un'affermazione causale[modifier | modifier le wikicode]

Nel caso di problemi legati a relazioni causali fuorvianti (multicausalità ed endogeneità), ci sono due modi per controllare empiricamente l'affermazione causale.

Analisi della covarianza (dati di osservazione)[modifier | modifier le wikicode]

- controllo: trasformazione di variabili esterne () in costanti, quindi non ha effetti, perché non c'è covarianza, non cambia. Dobbiamo prendere in considerazione le possibilità di relazioni ingannevoli (ad esempio, guardiamo tra tutti coloro che frequentano l'università nella classe sociale più alta, e poi analizziamo il loro voto; quindi la classe non avrà un ruolo nell'analisi). Questo controllo può essere fatto manualmente.

- depurazione: controllo statistico. Facciamo un modello statistico, introduciamo che la variabile , ci interessa, introduciamo variabili con una forte relazione, poi introduciamo le altre variabili di controllo, e se troviamo ancora un effetto tra e , significa che il rapporto non era fuorviante. Questo viene fatto da un computer che calcola le relazioni tra tutte le variabili e considera anche tutte le relazioni di co-variazione. Alla fine determina se c'è una falsa correlazione o meno. Il controllo statistico è un modo di controllare le variabili e permette di verificare empiricamente la relazione causa-effetto.

Esperimento (dati sperimentali)[modifier | modifier le wikicode]

E' l'implementazione di un metodo sperimentale. Nell'analisi della covarianza agiamo una volta che abbiamo i dati, cioè manipoliamo i dati a priori dal disegno di ricerca, mentre nel metodo sperimentale agiamo prima (come produciamo i dati?). Il metodo sperimentale è utilizzato per evitare una relazione fuorviante, un campione è diviso in due gruppi e gli individui sono selezionati in modo casuale. Secondo la legge dei grandi numeri, si può dimostrare che i due gruppi sono simili, quindi l'unica differenza sarà la variabile indipendente.

Conclusione: è una riflessione sulla causalità; è stato detto che la questione della causalità rimane a livello teorico, possiamo solo cercare di avvicinarci a questo ideale. Bisogna cercare una correlazione, ma bisogna escludere ipotesi (contro variabili), se non lo si fa si può cadere in una relazione causale fuorviante.

Covariazione: può essere vicino a una relazione causale, ma è l'effetto di un

(variabile non osservata) che influenza ciò che vogliamo spiegare (dipendente) e ciò che spiegherebbe ciò che vogliamo spiegare (indipendente). Una variabile influenza le altre due variabili contemporaneamente, vi è anche la possibilità di un'interazione tra variabili esplicative.

Come controllare le variabili per evitare di cadere in una relazione ingannevole? Ci sono due modi:

- analisi di covarianza: osserviamo (dati osservazionali) dopo averli avuti.

- controllo: faremo costante una variabile straniera, quando abbiamo un rapporto presunto tra due variabili che viene reso fallace, perché c'è una terza variabile, prendiamo una parte degli individui che corrisponde alla seconda variabile, ad esempio, prendiamo persone della stessa età, per il rapporto comportamentale tra esposizione televisiva e voto. Così abbiamo controllato questo valore, l'abbiamo reso costante.

- depurazione: è un controllo statistico. Depurazione per tutte le variabili.

- analisi sperimentale: abbiamo messo a punto un disegno di ricerca che evita l'esistenza di variabili Z che potrebbero influenzare la nostra analisi.

Quattro metodi scientifici fondamentali secondo Arend Lipjhart[modifier | modifier le wikicode]

Si possono menzionare tre o addirittura quattro metodi:

- Metodo sperimentale (si differenzia dagli altri)

- Metodo statistico

- Metodo comparativo

- Caso di studio

Questi sono i tre metodi fondamentali che permettono di controllare le variabili note anche come "fattori esplicativi aggiuntivi". L'obiettivo è quello di verificare le ipotesi ed escluderne alcune in concorrenza con altre.

I primi tre metodi, infine, hanno tutti l'obiettivo principale di ricercare rapporti di causa-effetto e di eliminare il rumore prodotto da che potrebbero produrre un rapporto fuorviante, hanno lo stesso scopo, ma lo perseguono in modo diverso. I tre stabiliscono proposizioni empiriche generali sotto il controllo di tutte le altre variabili (). Vogliono avvicinarsi al rapporto teorico causa-effetto tra un fenomeno osservato e le cause potenziali, ci sono diversi gradi di successo, abbiamo visto che il metodo sperimentale e quello più vicino ad esso, sui diversi fattori esplicativi. L'idea è di arrivare ad una conferma empirica delle affermazioni causali.

Metodo sperimentale[modifier | modifier le wikicode]

Principi[modifier | modifier le wikicode]

- Assegnazione casuale: selezionati a caso, tutti gli individui hanno le stesse probabilità di essere nel gruppo di controllo sperimentale o soggetto (nei gruppi di controllo sperimentale e non sperimentale). Questa idea è nata dal principio della legge dei grandi numeri: la variabile casuale dovrebbe escludere qualsiasi altra spiegazione.

- Manipolazione della variabile indipendente (trattamento), come sono uguali i gruppi? Il ricercatore, ad un certo punto, introduce un input in uno dei due gruppi.

Separiamo due gruppi in modo che i due gruppi siano gli stessi su tutte le dimensioni tranne che su una che è quella su cui vogliamo testare l'effetto. La selezione di una persona e l'assegnazione casuale rende i due gruppi simili. Se, successivamente, viene introdotto un trattamento in uno dei due gruppi e si osserva un cambiamento che non è nel gruppo di controllo, ci può essere un effetto causale che va in una riflessione di causa ed effetto. Si può pertanto concludere che la variabile introdotta ha un effetto causale.

Tipi di esperimenti[modifier | modifier le wikicode]

- In laboratorio (laboratory experiment): si tratta di esperimenti eseguiti in laboratorio e poi gli individui vengono divisi in gruppi ai quali vengono applicati stimoli per arrivare ad un riscontro di effetto o non effetto. Tuttavia, gli individui vengono prelevati dalle loro condizioni naturali che possono portare a risultati che sono legati all'artificialità delle condizioni sperimentali.

- Esperimento sul campo (field experiment): contesto naturale, possono essere coinvolti altri fattori. Si tratta di esperimenti che sono stati applicati nelle scienze politiche. I principi rimangono gli stessi con una distribuzione casuale dei soggetti in due gruppi; la variabile indipendente viene manipolata e poi si determina se c'è stato un effetto del trattamento sul gruppo sperimentale e non sul gruppo di controllo. In questo modo è possibile evitare di criticare l'artificialità degli esperimenti di laboratorio.

- Disegno quasi-sperimentale (quasi-experiment): questo disegno tiene presente che il ricercatore manipola la variabile indipendente, ma non ci sono allocazioni casuali di soggetti ad un gruppo sperimentale e ad un gruppo di controllo. Se lo facciamo, è perché non possiamo distribuirci a caso in due gruppi, siamo costretti a prendere i gruppi effettivamente esistenti. In altre parole, il ricercatore controlla il trattamento, ma non può assegnare i soggetti in modo casuale. A volte, quando siamo sul campo, è difficile fare le cose in modo diverso. Di solito questo è il metodo che usiamo, perché c'è un fattore che non possiamo controllare.

Esempio[modifier | modifier le wikicode]

Uno psicosociologo ha voluto testare gli effetti degli obiettivi collettivi sulle relazioni interpersonali. Voleva vedere fino a che punto, quando a un gruppo di persone viene detto che c'è un obiettivo, stereotipi negativi in conflitto scompaiono. È un'esperienza immediata in condizioni naturali. Ha lasciato che i bambini interagissero tra loro, i bambini collaborano tra loro; il ricercatore ha cercato di creare un'identità collettiva e ha diviso il gruppo in due in modo casuale. Li ha fatti giocare a calcio; abbiamo visto emergere rivalità e persino stereotipi negativi nei confronti dell'altra squadra. Poi ha rimesso insieme il gruppo e ha ridefinito un obiettivo comune che richiede cooperazione. In seguito, ha notato che questi conflitti, gli stereotipi negativi e le ostilità si sono trasformati in una vera e propria cooperazione.

Metodo statistico[modifier | modifier le wikicode]

Non possiamo fare un disegno di ricerca che a priori ci permette di verificare se ci sono relazioni di correlazione, ma dobbiamo farlo dopo il fatto.

- manipolazione concettuale (matematica) di dati empiricamente osservati: abbiamo dati osservazionali o cerchiamo di controllare per controllo statistico, con correlazioni parziali. Si distingue tra dati sperimentali e osservazionali.

- correlazioni parziali: correlazione tra due variabili una volta lasciata l'analisi, cioè il controllo dell'effetto di altre variabili che potrebbero influenzare ciò che si vuole spiegare. In altre parole, significa fare le altre Z come se fossero costanti a seguito di un processo di depurazione. E' una logica di controllo delle variabili: controlliamo le variabili che possono influenzare ciò che vorremmo spiegare. Nell'esempio sul voto, dovrebbe essere preso in considerazione tutto ciò che potrebbe spiegare il voto, soprattutto se si può presumere che questo fattore esterno possa influenzare sia il voto che la variabile indipendente (esposizione mediatica). In questo modo possiamo sapere se ci stiamo avvicinando a un effetto causale. Tradotto con www.DeepL.com/Translator

L'importante è andare oltre la semplice analisi bivariata; è necessario passare ad un'analisi multivariata dove altre variabili sono introdotte nel modello esplicativo.

Metodo comparativo[modifier | modifier le wikicode]

Tutta la ricerca nel campo delle scienze sociali è per sua natura comparativa. Confrontiamo sempre qualcosa in modo implicito o esplicito. Ci si può chiedere quali siano gli obiettivi del confronto. Abbiamo visto che gli obiettivi di qualsiasi metodo scientifico cercano di stabilire proposizioni empiriche generali controllando tutte le altre variabili, ma secondo alcune, come Tilly, ci sono quattro obiettivi per il confronto, cioè il confronto delle unità di osservazione.

Gli obiettivi del confronto secondo Charles Tilly sono:

- Individualizzazione (individualizing): l'obiettivo è quello di evidenziare ed evidenziare le caratteristiche di una data unità di analisi su un certo fenomeno; l'idea è quella di trovare confronti, di dare specificità ad un dato caso di esempio; negli studi di politica comparativa, il caso è il paese, i paesi sono confrontati; l'obiettivo è, ad esempio, di mostrare alcune caratteristiche del sistema politico svizzero rispetto ad altri paesi. La democrazia diretta determina i valori politici; la democrazia diretta svizzera può essere confrontata con paesi che non ne dispongono. Possiamo analizzare l'impatto di questa caratteristica sulle persone. Caratterizzare, individualizzare, personalizzare, rendere più specifiche le caratteristiche di un paese rispetto ad un altro.

- Generalizzare (generalizing) : non confrontiamo per individualizzare, ma per generalizzare, includiamo il maggior numero di casi, stabiliamo proposte empiriche generali. Per alcuni, la generalizzazione è uno dei due obiettivi principali del metodo comparativo. Studiamo i comportamenti che confrontiamo, vogliamo vedere se le configurazioni e gli effetti che troviamo in un contesto si trovano in un altro contesto.

- Ricerca di variazioni sistematiche (variation finding): l'obiettivo è quello di cercare variazioni sistematiche e testare una teoria scartando le teorie concorrenti da quella che si vuole evidenziare. Secondo Tilly, questo è il modo migliore per fare un confronto. Cerchiamo di testare un'ipotesi causale, quindi escludiamo ipotesi rivali.

- Globalizzazione (encompassing): l'obiettivo è quello di globalizzare (approccio sistemico) che comprende tutti i paesi del mondo, o tutte le possibili unità di confronto. L'idea è che se si rimuove una di queste unità di confronto, l'intero sistema cambia. Per il professor Giugni, questo non è un approccio comparativo, perché non c'è confronto.

Ci sono diversi obiettivi del confronto; agire sulla selezione dei casi è comparare.

Strategie di confronto per cercare variazioni sistematiche (Przeworski e Teune) Si può fare una distinzione tra due strategie di confronto, sono logiche e modi di procedere metodologicamente nella scelta dei casi. Questi sono modi per affrontare la questione della causalità quando sono disponibili dati osservazionali. Viene fatta una distinzione tra due progetti di ricerca comparativa, vale a dire il confronto per caso analogico (simile) e per contro caso (diverso). Ciascuna delle opzioni presenta vantaggi e svantaggi.

- Confronto tra casi contrastanti (la maggior parte dei sistemi di progettazione diversi): scegliamo casi che sono i più diversi possibili

- Confronto tra casi analoghi (progettazione di sistemi più simili): ha lo scopo di controllare tutte le variabili tranne quella che si vuole analizzare (esempio Francia - Svizzera).

Stuart Mill ha riflettuto su come analizzare questo nesso causale. Selezionando diversi casi per raggiungere questo ideale, puntiamo al rapporto di causa-effetto. Ma non siamo nel contesto del controllo statistico. Nel nostro caso, attraverso la selezione dei casi, cerchiamo di avvicinarci a questo ideale.

Stuart Mill distingue tra due casi:

- The method of agreement (the most different system design): la logica è quella di scegliere paesi molto diversi, ma che sono simili su un fattore chiave. C'è una X ovunque. Poi osserviamo Y, poi c'è una somiglianza nella variabile Y che vogliamo spiegare. La logica è quella di dire che stiamo cercando paesi dove troviamo lo stesso fenomeno, che è quello di cui vogliamo dimostrare l'effetto. Osserviamo quello che succede è che ogni volta che c'è la X troviamo la Y. In quel momento, è prodotto da X perché non può essere prodotto da nient'altro, perché gli altri fattori dei paesi sono diversi, non si trova da nessun'altra parte. La logica è quella di scegliere casi molto diversi sulla maggior parte dei fattori a cui si può pensare e poi si vedrà se c'è una compresenza della variabile che si vuole spiegare e di quella che spiega.

- The method of difference (the most similar system design): stiamo cercando paesi che sono il piu' simili possibile. Si può operare una distinzione tra casi positivi e negativi. Cercheremo i casi che hanno il fattore A, B e C e i casi negativi che hanno anche A, B e C. Nei casi positivi è presente un fattore che non è presente nei casi negativi. Quindi la votazione è presente quando X è presente e assente quando X è assente. La conclusione è che X è la causa dell'effetto Y, perché la presenza di almeno Y non può essere stata prodotta da A, B e C. Abbiamo reso costanti A, B e C.

Esempio - la maggior parte della progettazione del sistema: ci sono tre casi (1, 2, n); un caso può essere individuale, nazionale, ecc. Abbiamo una serie di qualità per questi casi. Queste sono caratteristiche dei diversi paesi (disoccupazione, sviluppo), X è la variabile indipendente e vogliamo spiegare Y. In questa logica di confronto, i casi sono molto diversi, ma sono simili in una sola proprietà. Quindi questa variabile spiega il fattore, perché è l'unico fattore comune. Nella Tabella 2 abbiamo casi positivi e negativi; questi casi sono perfettamente simili su quanti più attributi, proprietà e variabili possibili, ma c'è una differenza cruciale in ciò che si suppone di spiegare ciò che vogliamo spiegare. C'è un fattore che non è presente. In un caso c'è Y nell'altro passaggio; la differenza è attribuita alla variabile che non lo è in entrambi i casi. Questo metodo cerca di approssimare l'approccio sperimentale, perché è fatto in modo che i due gruppi siano il più possibile vicini (simili ad a, b, c), ma differiscono dalla variabile indipendente, più simile al disegno del sistema. Il professor Giugni preferisce questo modo, perché si avvicina all'ideale di sperimentazione. Un esempio è quello di studiare gli studenti che frequentano il corso nell'arco di due anni e cambiano le diapositive che vengono fornite. Poi, confrontiamo il risultato finale (il punteggio medio) in entrambi i casi.

Esempio - sistema più simile: confronto paesi simili (Francia e Svizzera), e voglio dimostrare che la repressione della polizia francese è più forte, è l'unico fattore che differisce da un paese all'altro. Poi vediamo che la radicalizzazione dei movimenti sociali è più forte in Francia. Il problema è che la "A", cioè i fattori che sono simili tra i due paesi, non sono mai uguali, ma solo simili (questo problema può essere trovato solo con il metodo di progettazione di ricerca più simile, motivo per cui ci sono ricercatori che preferiscono l'altro approccio, in cui è solo necessario trovare le differenze), possiamo solo avvicinarci all'ideale. Inoltre, troviamo il problema dell'endogeneità, cioè sapere quale fattore influenza l'altro.

Caso di studio[modifier | modifier le wikicode]

È un metodo più qualitativo, si differenzia dagli altri tre metodi in quanto sono più orientati alla ricerca quantitativa-positivista. Ci sono alcune distinzioni fatte da Arend Lipihart, c'è una sorta di scissione, una distinzione tra dati sperimentali e d'altra parte i dati di osservazione.

Mentre il metodo sperimentale si basa sull'idea di un gran numero, il metodo comparativo un numero di casi che possono variare, il caso studio si basa su un solo caso. Tuttavia, è possibile prendere in considerazione un caso di studio che può coprire più di un caso, in quanto il confine è a volte flessibile.

Il caso di studio è solo lo studio di un caso, non ha alcun confronto. Un caso può essere costituito da molte cose come una festa, una persona o un paese. Cerchiamo di studiare un caso particolare in modo approfondito, ma non in modo estensivo come gli altri tre metodi che non studiano i casi in modo così approfondito.

In altre parole, il grande vantaggio del caso di studio è che si può andare molto più a fondo nella conoscenza del caso. Uno studio di caso è per definizione intensivo, mentre lo studio quantitativo è ampio. Un metodo si basa su standard con l'idea di generalizzare mentre l'altro si basa su un'interpretazione approfondita di un caso specifico.

Se il metodo statistico mira a generalizzare, il caso studio per definizione non consente la generalizzazione, l'obiettivo è un altro. Esistono diversi studi di caso e diversi modi di condurre un caso studio. Possiamo citare 6 varianti:

- i primi due dei quali sono destinati a concentrarsi sul caso specifico.

- le altre quattro modalità hanno l'obiettivo di creare o generare una teoria.

Il caso studio può essere utilizzato per raggiungere diversi obiettivi, da un lato si vuole conoscere meglio una particolare situazione in modo descrittivo, dall'altro si possono studiare diversi casi che permettono di generare una teoria a lungo termine.

Secondo Arend Lipihart, lo scopo della ricerca è quello di testare e verificare una teoria e di generalizzare i risultati.

Questi due casi non vogliono creare ipotesi, l'idea è quella di far luce su qualcosa in relazione a un caso:

- ateorico: non c'è teoria, è puramente descrittivo. Si tratta di ricerca esplorativa, ad esempio, lo studio di una nuova organizzazione, vogliamo solo conoscerla e descriverla, nel qual caso non possiamo generalizzare i risultati, perché sono legati ad un caso particolare studiato. Viene utilizzato in situazioni o casi che non sono mai stati studiati prima.

- interpretativo: usiamo proposte teoriche che esistono in letteratura, in questo approccio qualitativo il ruolo della letteratura è meno importante, applichiamo una generalizzazione esistente ad un caso dato, qui il caso riguarda un caso specifico, senza la volontà di creare una teoria proprio come l'ateo. L'obiettivo non è di confermarlo o negarlo, ma solo di applicarlo. Le proposte o teorie esistenti sono utilizzate e applicate ad un caso; le generalizzazioni esistenti sono applicate ad esso per vedere se la generalizzazione è basata su quel caso specifico. Una situazione particolare viene interpretata alla luce di una teoria esistente.

I prossimi quattro vogliono creare una teoria o trarre qualcosa dai casi. Il loro obiettivo è quello di creare o generare teorie o ipotesi:

- generare ipotesi: vogliamo creare ipotesi dove non ce ne sono. Studio un caso non solo perché mi interessa, ma perché voglio formulare ipotesi che proverò altrove. Ad esempio: un'organizzazione che si occupa di politica. Studiamo una data situazione perché vogliamo ipotesi che non possiamo trovare altrove. Si esplora un caso per formulare ipotesi. Le ipotesi hanno essenzialmente tre fonti: letteratura esistente, immaginazione sociologica, studi esplorativi.

- confermando una teoria: testando una teoria su un caso particolare per confermare questa teoria, questo tipo di studio di caso non è molto utile, perché non è il fatto che c'è un caso che riflette una teoria esistente che rafforzerà la teoria che rende questo sistema poco utile.

- invalidare una teoria: questo è molto più prezioso, c'è una teoria che viene applicata in un caso specifico, non cerchiamo di confermare la teoria, ma per dimostrare che non funziona, cerchiamo di invalidare una teoria. Questo ci porta a pensare alla teoria, è qualcosa di importante per sviluppare una teoria.

- caso deviante: perché un caso si discosta dalla generalizzazione, questo caso è molto utile quando si vuole confutare una teoria. Stiamo cercando una situazione che si discosta da una situazione esistente, il caso studio cerca di mostrare perché questo caso si discosta dalla generalizzazione.

Allegati[modifier | modifier le wikicode]

- Elisabeth Wood - An Insurgent Path to Democracy: Popular Mobilization, Economic Interests and Regime Transition in South Africa and El Salvador," Comparative Political Studies, October 2001. Translation published in Estudios Centroamericános, No. 641-2, 2002. url: http://cps.sagepub.com/content/34/8/862.short